Screaming Frog SEO Spider jest zaawansowanym crawlerem stron internetowych, wykorzystywanym przez większość specjalistów SEO. Pozwala on kompleksowo przeanalizować najważniejsze czynniki „on-site”, dostarczając informacje na temat słabych i mocnych stron witryny. Narzędzie szczególnie przydaje się podczas wykonywania audytów SEO, gdyż wykrywa on liczne nieprawidłowości związane z meta tytułami, duplicate contentem, errorami strony oraz nagłówkami Hx. Program dostępny jest w darmowej wersji, obsługującej 500 przypadkowych adresów URL oraz w pełnej, oferującej cały wachlarz możliwości.

Artykuł odpowiada na pytania:

- Jakie funkcje posiada Screaming Frog SEO Spider?

- Jakie czynniki „on-site” można przeanalizować za pomocą Screaming Froga?

- Jak wykonać audyt SEO za pomocą Screaming Frog SEO Spider?

Spis treści:

Strony bez nagłówka H1

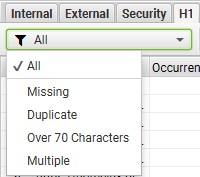

Nagłówek H1 jest istotnym elementem strony internetowej, dostarcza robotom Google oraz użytkownikom informacji, o czym jest podstrona. Aby Google mógł zidentyfikować tytuł główny, powinien on zostać oznaczony w kodzie jako H1. W Screaming Frog uzyskamy informację o ilości nagłówków oraz długości tekstu.

Analiza nagłówków (źródło: Screaming Frog SEO Spider)

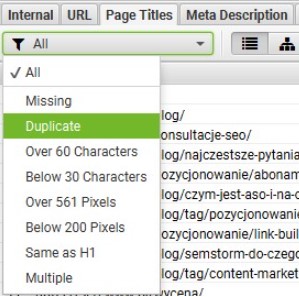

Title oraz meta description – duplikacje

Screaming Frog umożliwia znalezienie zduplikowanych title oraz meta description. Po zakończonym crawlu przechodzimy do zakładek Page Titles oraz Meta description. Program umożliwia filtrowanie wyników ze względu na ich duplikacje, brak, ilość znaków lub pixeli.

Analiza tytułów (źródło: Screaming Frog SEO Spider)

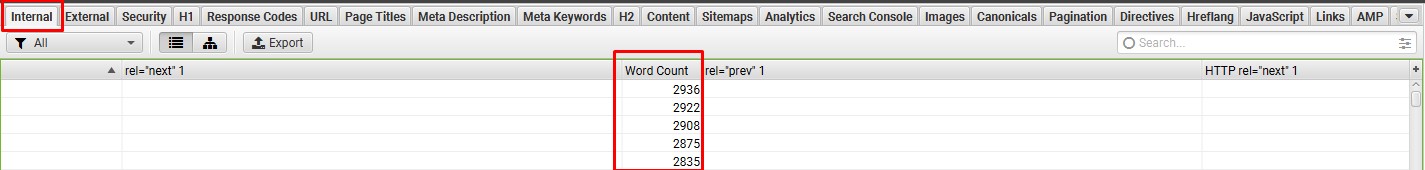

Liczba słów na stronie

Istotnym elementem w trakcie prowadzenia działań SEO jest content, bez którego ciężko jest uzyskać wysokie pozycje. W narzędziu zweryfikujemy jaką ilość słów mają konkretne podstrony i tym samym znajdziemy takie, które tych treści mają mało. Dane znajdują się w zakładce “Internal” oraz kolumnie “Word Count”. Pamiętaj o tym, że wskazane liczby obejmują wszystkie elementy na stronie tj. menu, stopka oraz inne bloki tekstu.

Analiza liczby słów (źródło: Screaming Frog SEO Spider)

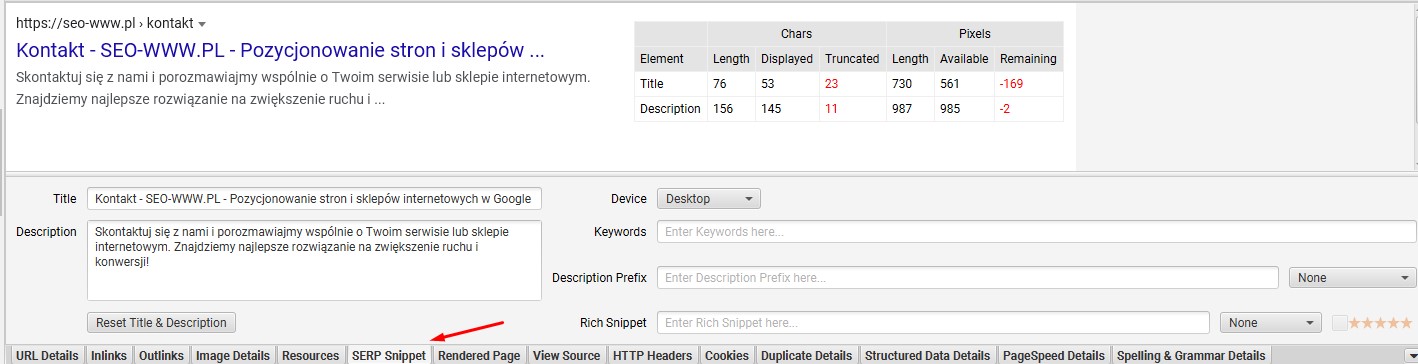

“Podgląd” wyglądu SERP’a

Jeśli zastanawiasz się, jak wybrany URL prezentuje się w wyszukiwarce Google, za pomocą Screaming Froga możesz to sprawdzić w zakładce “SERP Snippet”, znajdującej się w dolnej sekcji. Program dostarcza dane o długości title oraz meta description, jeśli jednak nie jest on uzupełniony, pole będzie puste.

Analiza wyniku w SERP (źródło: Screaming Frog SEO Spider)

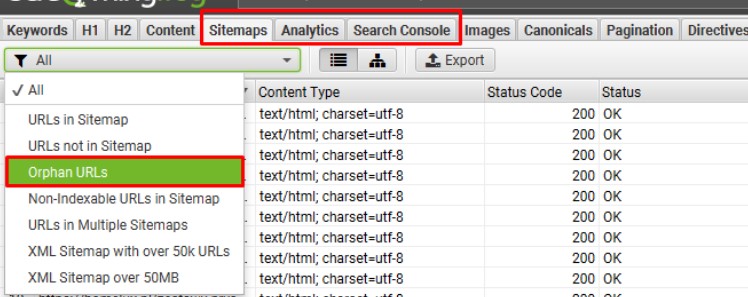

Analiza stron osieroconych – orphan pages

Strony osierocone to adresy URL, których nie można znaleźć wyszukując wewnętrzne linki witryny. Użytkownicy oraz roboty Google mogą mieć problem, aby dostać się do strony, co przekłada się na gorszą widoczność tych adresów. Powstają one z różnych powodów m.in.: zmiana architektury strony, podstrony wygenerowane przez CMS lub wyprzedane produkty, które nadal istnieją.

Analiza orphan pages możliwa jest wyłącznie w płatnej wersji programu, gdyż wymagana jest integracja z Google Analytics oraz Search Console.

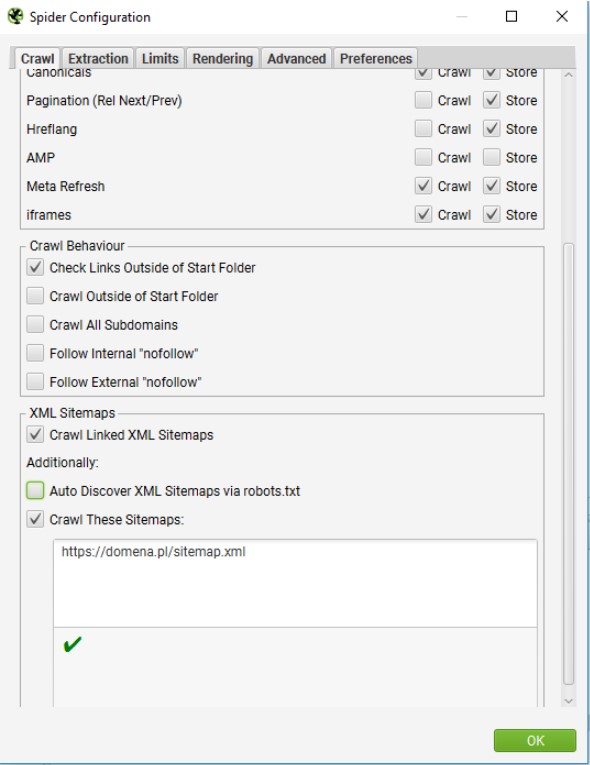

Pracę nad znalezieniem orphan pages rozpoczynamy od konfiguracji oraz dodania adresu sitemapy. Wchodzimy do: Configuration -> Spider. Zaznaczamy Crawl Linked XML Sitemaps, Crawl These Sitemaps oraz podajemy adres URL.

Analiza „Orphan pages” (źródło: Screaming Frog SEO Spider)

Program wyszuka orphan pages w obrębie sitemapy.

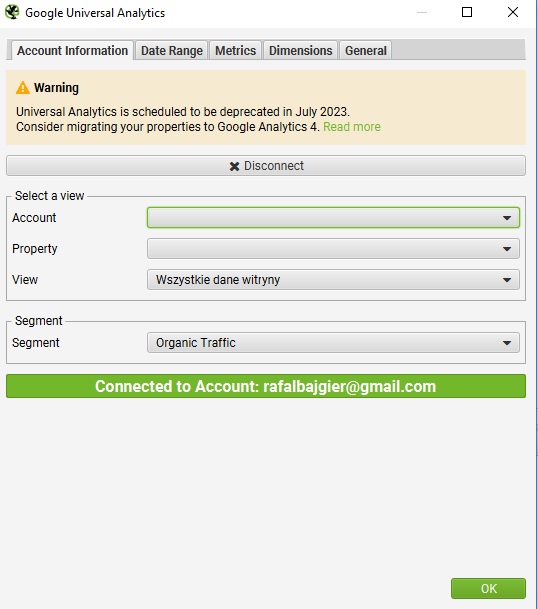

Następnie konfigurujemy Google Analytics, aby zebrać z niego dane. Wchodzimy do: Configuration -> API Access -> Google Analytics (UA lub GA4). Dobieramy odpowiednie dane pod kątem analizowanej strony oraz wybieramy segment “Organic Traffic”. W Date Range ustawiamy interesujący okres pobieranych danych, np. ostatnie 30 dni.

Konfiguracja Google Analytics (źródło: Screaming Frog SEO Spider)

W kolumnie General zaznaczamy opcję “Crawl New URLs Discovered in Google Analytics”.

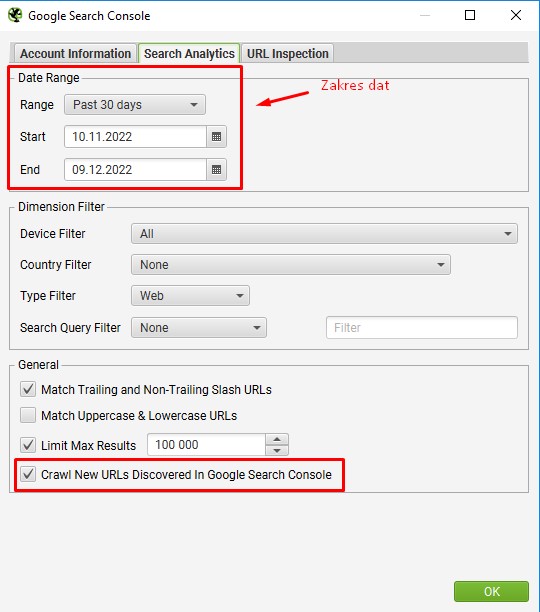

Kolejnym działaniem jest konfiguracja Google Search Console. Wykonujemy to w lokalizacji: Configuration -> API Access -> Google Search Console. W kolumnie Search Analytics ustawiamy interesujący zakres dat oraz zaznaczamy “Crawl New URLs Discovered in Google Search Console”.

Konfiguracja Google Search Console (źródło: Screaming Frog SEO Spider)

Wykonujemy standardowy crawl serwisu. W zakładce API znajdziemy informacje, czy podczas trwania procesu powstały błędy.

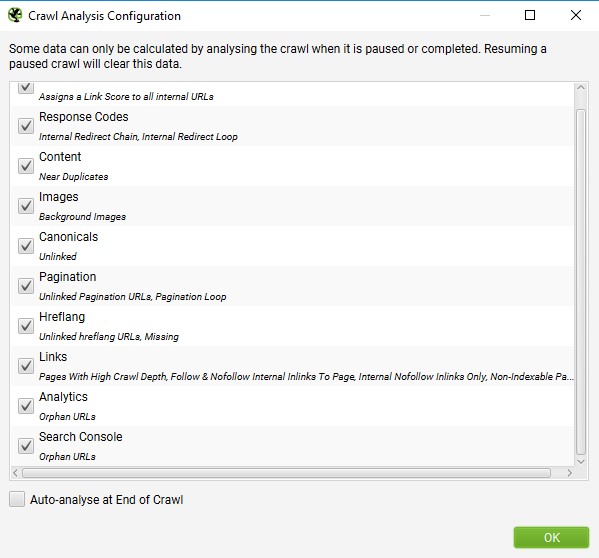

Po zakończonym crawlu wchodzimy do: Crawl Analysis -> Configure i zaznaczamy: Sitemaps, Analytics oraz Search Console.

Konfiguracja analizy (źródło: Screaming Frog SEO Spider)

Następnie: Crawl Analysis -> Start

Dane o orphan pages znajdują się w zakładkach:

Analiza znalezionych „Orphan pages” (źródło: Screaming Frog SEO Spider)

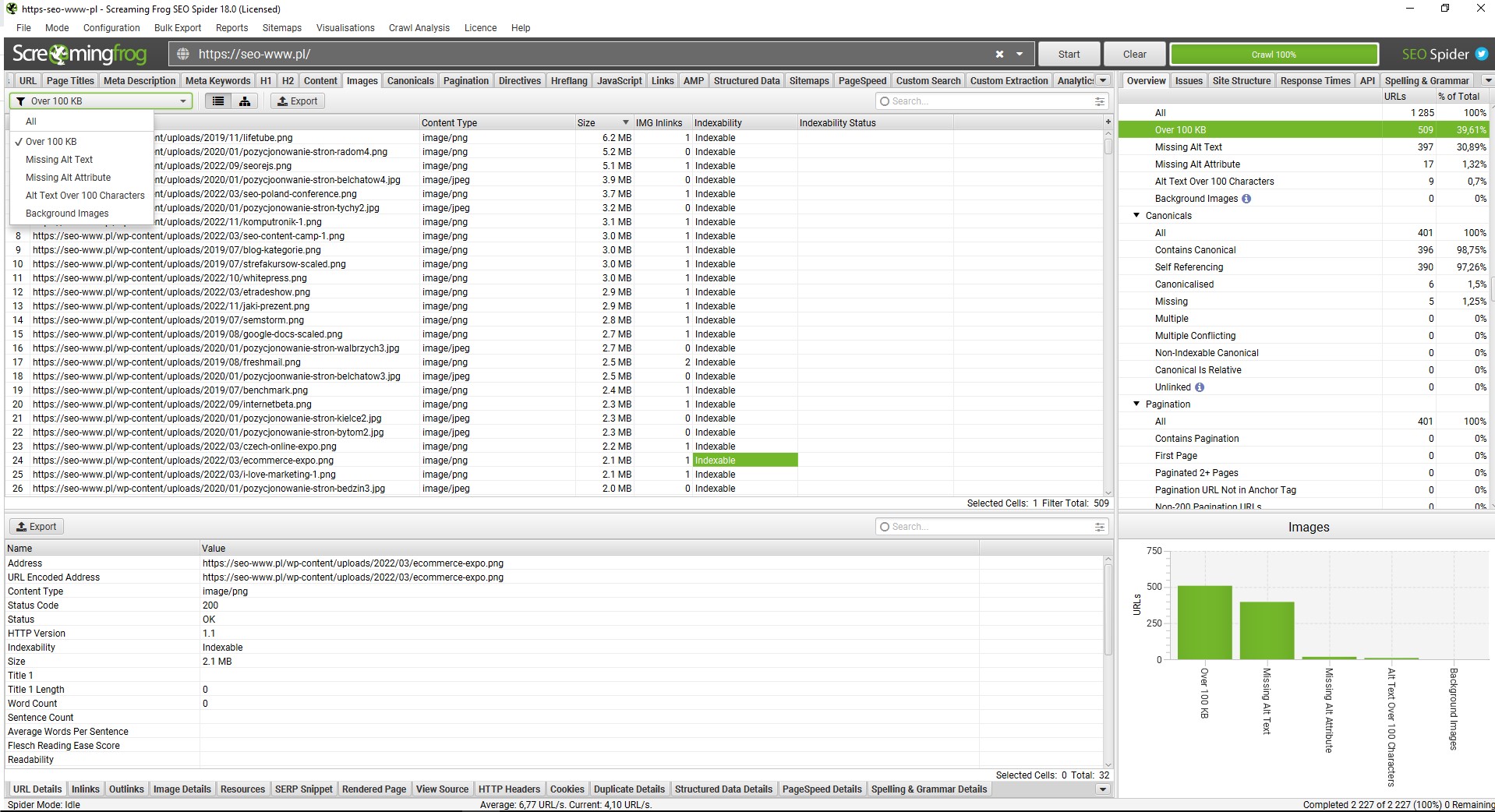

Zdjęcia w serwisie – waga oraz ALT-y

Ciężkie zdjęcia o wysokiej rozdzielczości spowalniają stronę oraz negatywnie wpływają na odczucia użytkownika. Screaming Frog w prosty sposób pozwala znaleźć najbardziej problematyczne obrazy. Dane znajdują się w kolumnie “Images”, które można posortować malejąco lub rosnąco. Filtr “Over 100 KB” wskaże jedynie problematyczne zdjęcia.

Analiza wagi zdjęć (źródło: Screaming Frog SEO Spider)

W tym segmencie programu otrzymujemy również informacje o zdjęciach bez tekstu alternatywnego ALT, który powinien opisywać to, co znajduje się na obrazie. Odpowiednio skonstruowany tekst wpłynie na lepszą widoczność w organicznych wynikach Google Grafika. Dane znajdziemy w lokalizacji: Images -> Filter -> Missing Alt Text

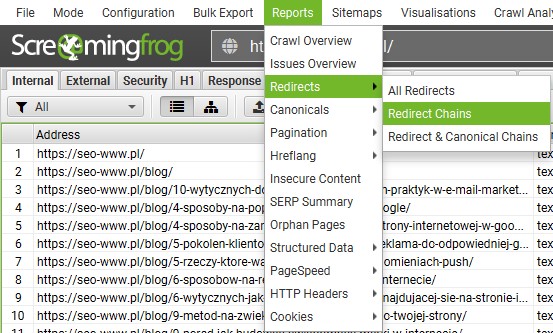

Redirect Chain – łańcuch przekierowań

Łańcuchy przekierowań są elementem, którego powinniśmy unikać podczas pozycjonowania strony internetowej. Występują one w przypadku, gdy link wewnętrzny przekierowuje przynajmniej dwa razy np. Link A -> Link B -> Link C. Najlepszym rozwiązaniem w takim przypadku jest wygenerowanie bezpośredniego przekierowania z Link A -> Link C.

Aby zweryfikować problematyczne adresy URL przed crawlem serwisu w konfiguracji zaznaczamy opcję podążania za przekierowaniami. Znajduje się ona w lokalizacji: Configuration -> Spider -> Advanced -> Always Follow Redirects. Spis adresów URL z łańcuchem przekierowań znajduje się w lokalizacji: Reports -> Redirects -> Redirects Chains w formie pliku Excel.

Analiza łańcuchów przekierowań (źródło: Screaming Frog SEO Spider)

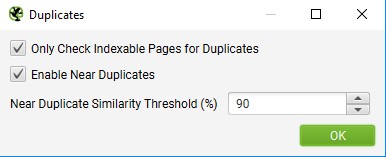

Duplicate Content

Screaming Frog pozwala na szybkie znalezienie stron posiadających duplicate content. Wyszukujemy: Configuration -> Content -> Duplicates.

W domyślnych ustawieniach program identyfikuje dokładnie zduplikowane podstrony, a drobne modyfikacje pozwalają na przeszukiwanie strony pod kątem duplikatów przy wybranym % podobieństwa. Opcja umożliwia analizę podstron, które nie posiadają blokady przed indeksacją.

Konfiguracja analizy duplikacji treści (źródło: Screaming Frog SEO Spider)

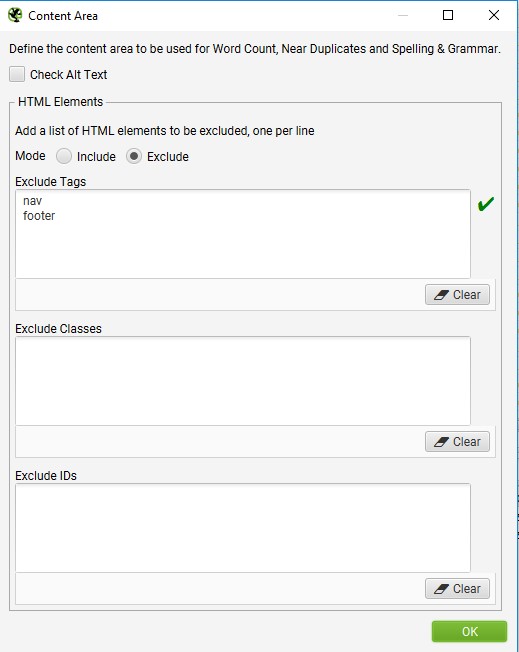

Narzędzie podczas crawlowania w domyślnych ustawieniach posiada wykluczenie elementów nawigacji oraz stopki dla stron zbudowanych w HTML5. W opcjach: Configuration -> Content -> Area istnieje możliwość wskazania tagów, class oraz ID, które nie powinny być brane pod uwagę.

Konfiguracja analizy tagów HTML5 (źródło: Screaming Frog SEO Spider)

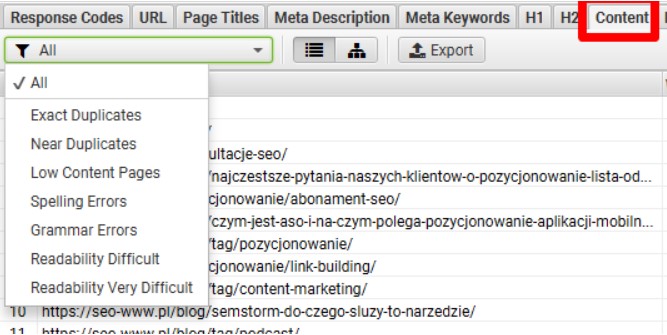

Po wstępnych ustawieniach wykonujemy crawl serwisu. Pełne dane odnośnie duplikacji znajdują się w zakładce Content. Zakładka filtrów pozwala na znalezienie konkretnych informacji.

Filtrowanie danych dla duplikacji treści (źródło: Screaming Frog SEO Spider)

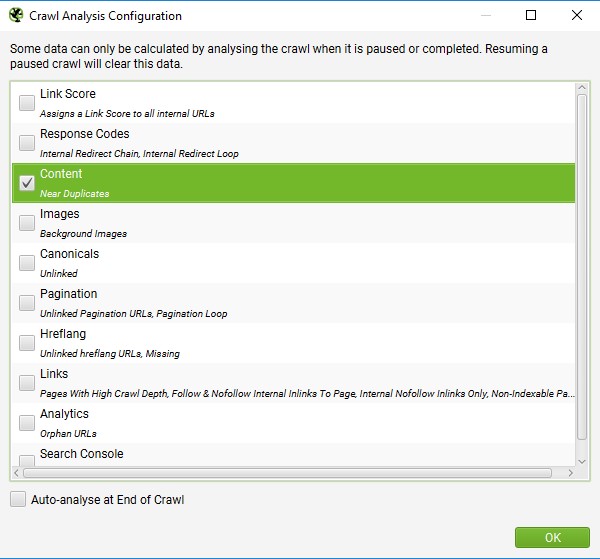

W podanych danych nie znajdziemy “Near Duplicates”, wymagane jest wykonanie dodatkowego przeszukania. Aby to wykonać przechodzimy do: Crawl Analysis -> Start. W konfiguracji musi być zaznaczona opcja Contentu.

Konfiguracja analizy duplikacji (źródło: Screaming Frog SEO Spider)

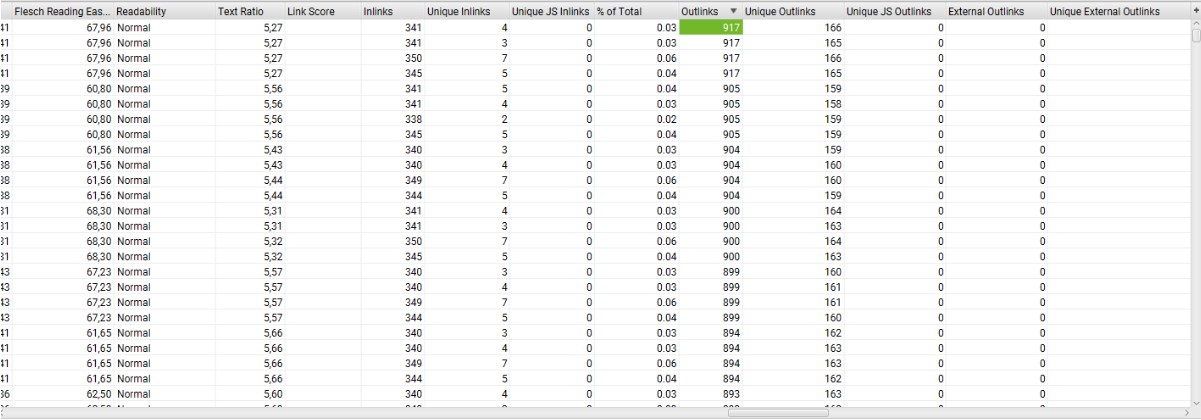

Identyfikacja podstron z dużą ilością linków wychodzących

Screaming Frog pozwala na identyfikację adresów URL z dużą ilością linków wychodzących. Program zlicza wszelkie typy tj. zewnętrzne, wewnętrzne, nofollow oraz dofollow. Dane znajdują się w zakładce Internal w kolumnie Outlinks.

Analiza linków wychodzących (źródło: Screaming Frog SEO Spider)

Więcej informacji odnośnie do linków wychodzących (typ, miejsce docelowe, follow/nofollow) znajduje się w dolnej części OutLinks.

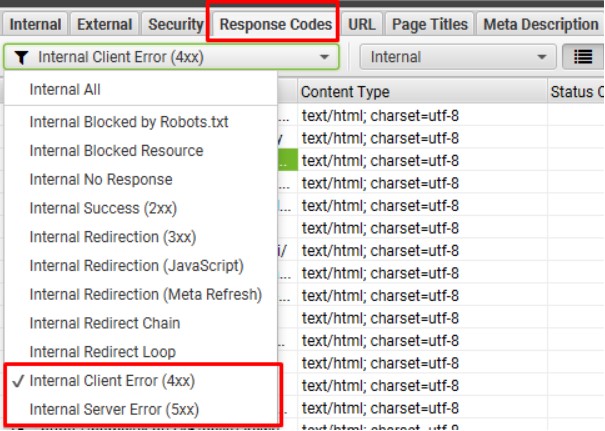

Broken links

Screaming Frog pozwala na znalezienie popsutych adresów url z kodem 4xx oraz 5xx. Po wykonanym crawlu przechodzimy do zakładki Response Codes. Program dostarcza dane o błędnych adresach URL analizowanej strony lub takiej, do której znajdują się linki np. zdjęcia.

Analiza błędów typu „404” (źródło: Screaming Frog SEO Spider)

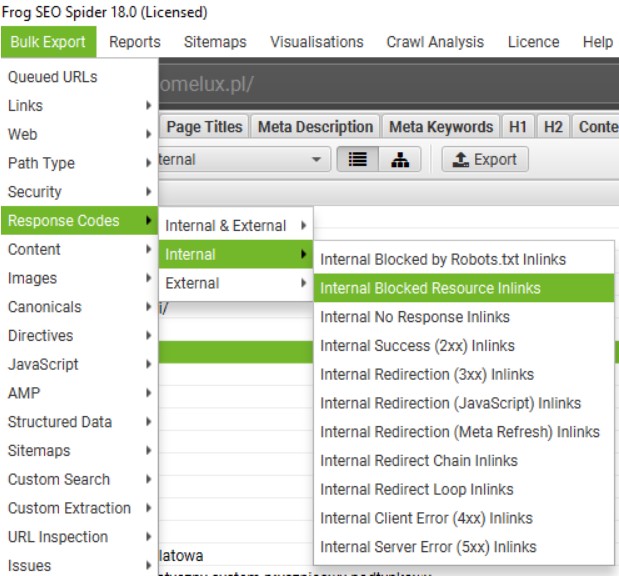

Po wyfiltrowaniu wybranego błędu np. 4xx oraz 5xx, w dolnej sekcji Inlinks uzyskamy informacje o tym, jakie adresy URL linkują do podstrony z błędem. Do prostszej obróbki przy dalszych pracach optymalizacyjnych, najprościej jest wyeksportować wybraną sekcję. Wykonujemy to w lokalizacji: Bulk Export -> Response Codes -> Internal -> wybrana opcja.

Masowa analiza błędnych linków wewnętrznych (źródło: Screaming Frog SEO Spider)

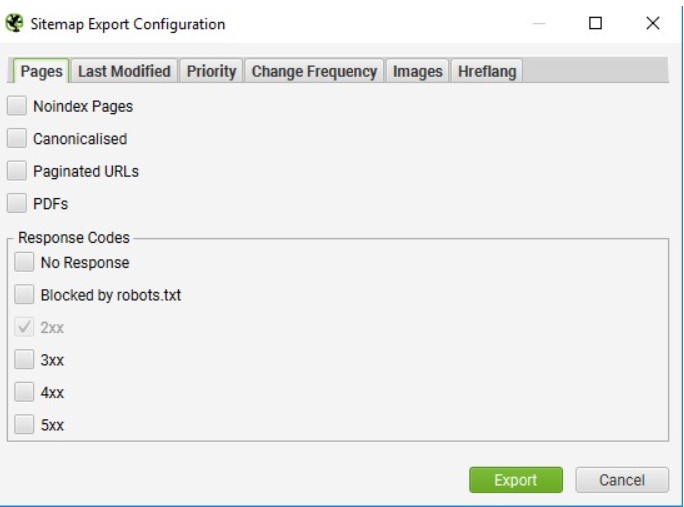

Generowanie sitemapy

Sitemapa to zbiór linków w obrębie jednej witryny. Zadaniem mapy strony jest umożliwienie robotom wyszukiwarek internetowych skuteczniejszą indeksację. Generowanie sitemapy rozpoczynamy od wykonania crawlu serwisu. Gdy otrzymamy już pełną listę adresów email klikamy w zakładkę: Sitemaps -> XML Sitemap i przechodzimy do wyboru stron, które znajdą się w mapie.

Domyślne ustawienia programu zawierają adresy z kodem 2xx, natomiast wykluczone zostają:

- podstrony paginacji;

- strony wykluczone w robots.txt;

- adresy kanoniczne;

- pliki PDF.

Sitemapę można dostosować do swoich preferencji zgodnie z ustawieniami, jakie oferuje program.

Konfiguracja mapy linków wewnętrznych (źródło: Screaming Frog SEO Spider)

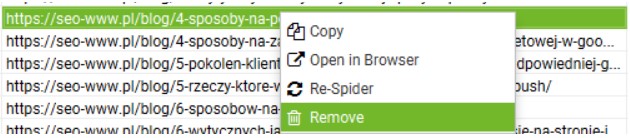

Jeśli nie chcemy w sitemapie posiadać wybranych adresów z kodem 2xx np. podstrony autorów lub tagi, w zakładce Internal możemy usunąć dowolny adres URL. Klikamy prawy przycisk myszki i Remove.

Usuwanie adresu URL z mapy linków wewnętrznych (źródło: Screaming Frog SEO Spider)

Pamiętaj o tym, aby wygenerowaną mapę strony dodać do plików na serwerze i wdrożyć ją do Google Search Console.

Masowy PageSpeed Insights

PageSpeed Insights to narzędzie znane prawdopodobnie każdemu specjaliście SEO. Problem jednak przychodzi, gdy masowo chcemy przeanalizować stronę pod tym kątem. Analiza kilkuset URL będzie czasochłonna i wymagająca sporo nużącej pracy. Z pomocą przychodzi Screaming Frog oraz PageSpeed Insights API.

Klucz do API zdobywamy zgodnie z instrukcjami podanymi tutaj (pamiętajmy o tym, aby włączyć możliwość korzystania z API na koncie Google – tutaj).

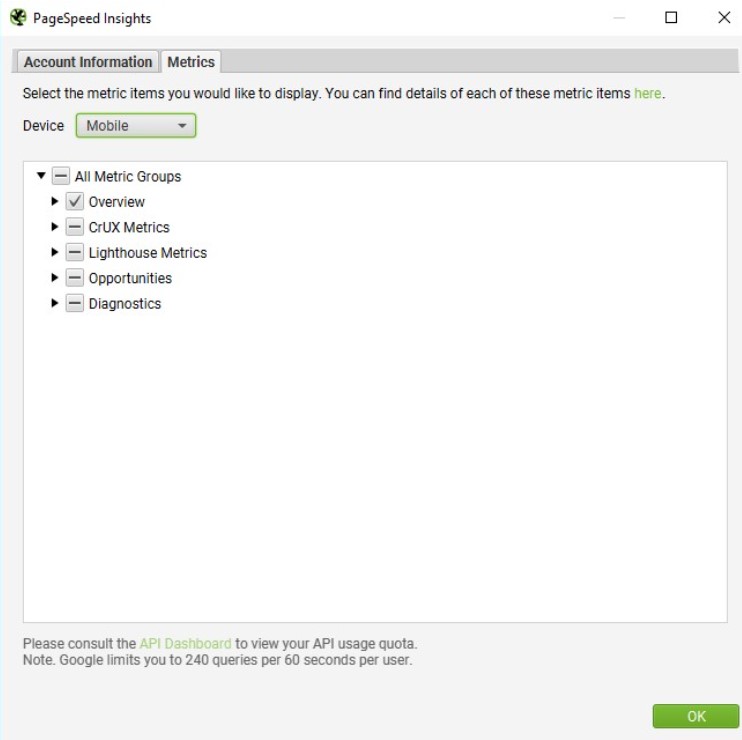

Przechodzimy do sekcji: Configuration > API Access > PageSpeed Insights i wdrażamy tam klucz.

Po nawiązaniu połączenia w ustawieniach, modyfikujemy jakie dane nas interesują oraz z jakiego urządzenia.

Konfiguracja analizy prędkości wczytywania (źródło: Screaming Frog SEO Spider)

API posiada limit 25000 zapytań dziennie oraz 240 na minutę. Po wykonanym crawlu rozpocznie się proces sprawdzania URL. Pozyskane dane znajdziemy w kolumnie PageSpeed.

Poszukujesz agencji SEO w celu wypozycjonowania swojego serwisu? Skontaktujmy się!