Jak wybrać hosting SEO z myślą o pozycjonowaniu?

W grudniu 2020 na facebookowej grupie SEO/SEM Polska pojawiło się pytanie o to, czy hosting SEO wpływa na efekty pozycjonowania? Okazuje się, że odpowiedź na pytanie o związki między serwerem i pozycjonowaniem strony nie jest wcale krótka i prosta. Zasadniczo wpływ jak najbardziej istnieje, natomiast jest on wielowymiarowy i myśląc nad wybraniem najlepszego hostingu dla Twojego SEO trzeba rozważyć kilka elementów.

Artykuł odpowiada na pytania:

- Czym się kierować podczas wyboru hostingu SEO?

- Jakie funkcje serwera wpływają na bezpieczeństwo serwisu?

- Jakie elementy wpływają na niezawodność serwera hostingowego?

Spis treści:

Szybkość strony

Szybkość wczytywania strony, zdaniem Google, ma znaczenie od 2010 roku, wówczas pojawiły się na oficjalnym blogu pierwsze wzmianki na ten temat. W 2018 roku Google ponownie oficjalnie odniosło się do tego zagadnienia wspominając o tym, że szybkość będzie czynnikiem rankingowym w odniesieniu do mobile.

Podstawowe wskaźniki internetowe Core Web Vitals

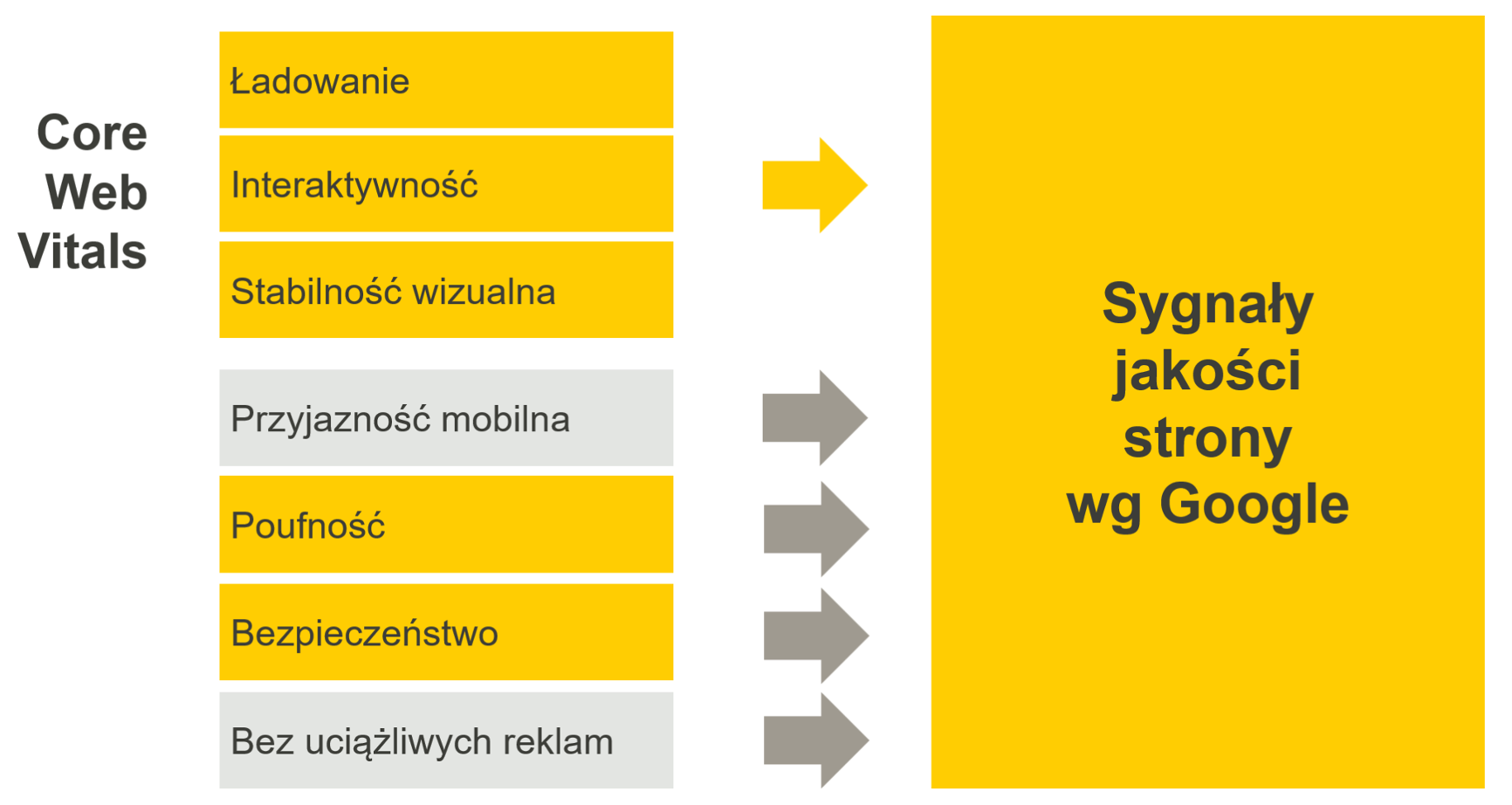

W maju 2020 świat SEO elektryzuje koncepcja Core Web Vitals. Google mówi o siedmiu istotnych czynnikach, jakie bierze pod uwagę kształtując swoją ocenę jakości strony – aż trzy z nich odnoszą się bezpośrednio do szybkości.

Przypomnijmy, że mowa o następujących parametrach:

- largest contentful paint – LCP – czas wyrenderowania największego elementu strony;

- first input delay – FID – moment uzyskania responsywności

- cumulative layout shift – CLS – wskaźnik wizualnej stabilności.

Wydajny serwer i dobre cacheowanie znacznie poprawiają wydajność i szybkość stron www… o ile się je prawidłowo włączy i skonfiguruje. Samo przeniesienie się na “szybki hosting” zazwyczaj nie da Ci efektu, jeśli nie zaczniesz korzystać z jego możliwości i nie dopasujesz strony do infrastruktury.

Przykładowo, jeśli operatora działa w oparciu o Litespeed – a Ty masz stronę na WordPress, polecam wtyczkę LSCache, w której łatwo włączysz wszystkie opcje przyspieszające. Współpracuje ona z odpowiednim oprogramowaniem po stronie serwera.

Serwery mają limity bezpieczeństwa. Wiedziałeś o tym?

Większość hostingów współdzielonych działa w oparciu o limity bezpieczeństwa. Kiedy zostają naruszone – np. dojdzie do wysycenia limitów procesów PHP, to strona przestaje działać.

Jest to konieczne dla zachowania stabilności serwera jako całości, natomiast kiedy dzieje się tak w chwili, kiedy Google Bot próbuje wejść na Twoją stronę – naraża Cię to na problemy z indeksowaniem. Strona może zostać uznana za mniej wiarygodną.

Najważniejsze limity bezpieczeństwa, które mogą wpływać na działanie Twojej strony, to:

- limit jednoczesnych procesów – głównie chodzi o jednoczesne procesy PHP, które, przy zwiększonej liczbie odwiedzin oraz niedostatecznej optymalizacji strony, mogą okazać się niewystarczające;

- limit plików na serwerze – jeśli przechowujesz wiele stron, zwłaszcza sklepów, na jednym koncie hostingowym, może się okazać, że limit plików okaże się wąskim gardłem;

- limit pamięci RAM dla skryptów PHP – w tym wypadku niektóre, zwłaszcza źle napisane skrypty, mogą mieć problemy, jeśli zajmą zbyt wielką porcję pamięci RAM. Co istotne, limit pamięci przyznany przez operatora hostingu może być wyższy niż ten domyślny, który masz ustawiony dla Twojej domeny – dlatego sprawdź, czy w pełni korzystasz z możliwości udostępnionej przez firmę hostingową i w razie konieczności ustaw większy zasób pamięci dla skryptów PHP poprzez ręczny wpis w php.ini lub poprzez funkcję w panelu administracyjnym;

- limit połączeń do bazy danych – jeśli masz źle przygotowany sklep, który wykonuje wiele obciążających zapytań SQL, aby wyrenderować stronę – może się zdarzyć, że przy większym ruchu przestanie działać prawidłowo.

Wybierając hosting pamiętaj, że zazwyczaj limity określone przez operatora są odpowiednie do utrzymywania pojedynczego serwisu (bądź kilku mniejszych). Jeżeli na jednym koncie umieścisz zbyt wielu klientów – może okazać się, że limity te staną się wąskim gardłem. W takim wypadku rozważ przejście na usługę bardziej zaawansowaną (vps, serwer dedykowany) lub podzielenie swoich klientów pomiędzy kilka kont hostingowych.

Niezawodność

To, jak wysoce niezawodne są serwery danego operatora wpływa na potencjalne przestoje. A przestoje oznaczają negatywny wpływ na Google Bota! Problem z działaniem serwera w chwili, kiedy odwiedza Cię Google Bot może prowadzić do trudności z zaindeksowaniem strony, a także powodować spadki pozycji strony już zaindeksowanej. Większość specjalistów uważa, że jeśli mówimy o krótkich awariach – liczonych w godzinach lub 1-2 dni – po przywróceniu serwera do działania pozycje także powrócą.

Operator, który zapewnia wyższy poziom niezawodności oraz posiada lepszy system kopii zapasowych – może być korzystny ze względu na czas ewentualnego przestoju.

W roku 46 p.n.e. doszło do pożaru Biblioteki Aleksandryjskiej – centrum danych ówczesnego świata. Tyle tylko, że dane były przechowywane w formie pergaminowych zwojów. Mija jednak 2 tysiące lat i w 2021 roku, w Paryżu, dochodzi do ogromnego pożaru współczesnego centrum danych. Złośliwi mówią, że tysiące serwerów przeniosło się do chmury…

Ten przykład pokazuje dobitnie, że kopie zapasowe to poważna sprawa, a nasza cywilizacja wciąż nie jest w pełni zabezpieczona przed zdarzeniami typu pożar, trzęsienie ziemi, powódź czy katastrofa budowlana.

Dlatego wybieraj firmę hostingową, która przechowuje kopie zapasowe – także poza swoim głównym data center. W takim wypadku będziesz mieć szansę na przywrócenie danych nawet w obliczu poważnej katastrofy.

Z rzeczy, które przydadzą się częściej – zwracaj uwagę na, nomen omen, częstotliwość wykonywania kopii zapasowych. Jeśli odpowiadasz za sklep internetowy warto, aby kopie, zwłaszcza kopie baz, były wykonywane kilkukrotnie w ciągu doby, a nie tylko raz dziennie.

Istotny jest także okres przechowywania kopii zapasowych. Istnieją tu ogromne różnice pomiędzy operatorami. Na rynku funkcjonują firmy oferujące przechowywanie kopii zapasowej przez 1,2 bądź 3 dni, ale są tutaj też operatorzy oferujący nawet wielotygodniowe przechowywanie backupów.

To ważne, bo w razie zainfekowania Twojej strony złośliwym oprogramowaniem – może się okazać, że taka kopia sprzed momentu infekcji ułatwi Ci namierzenie i rozwiązanie problemu. Pamiętaj tylko, że jej wgranie i nadpisanie zainfekowanego serwisu nie załatwi sprawy – przecież w niej tkwi podatność, przez którą doszło do infekcji, konieczne będą dalsze działania. Zawsze jednak o wiele lepiej tę kopię po prostu mieć, prawda?

Wybieraj firmę, która przechowuje kopie zapasowe dłużej niż twój najdłuższy wyjazd urlopowy i przechowuje je w alternatywnym centrum danych.

Złe sąsiedztwo

Reputacja Twojej strony zależy od adresu IP oraz tego, jakie inne strony są obsługiwane na tym samym serwerze. Jeśli są to strony ze złośliwym oprogramowaniem, strony spamerskie – może to przyczynić się do obniżenia wiarygodności Twojego serwisu.

Matt Cutts odniósł się do tego zagadnienia w materiale video o tym, czy złe sąsiedztwo może zaszkodzić Twojej stronie – jednak w jego ocenie takie sytuacje mają miejsce przede wszystkim wtedy, kiedy “sąsiedztwo” jest naprawdę bardzo, bardzo, bardzo złe

Cutts mówi, że sprawy mogą wyglądać dziwnie, kiedy masz np. 26 tysięcy spamujących stron porno na jednym adresie IP i wśród nich JEDNĄ normalną stronę. W takim wypadku można się zastanawiać, natomiast na każdym hostingu znajduje się “normalny” miks stron zainfekowanych lub spamujących i stron zdrowych. Google ma tę świadomość. W większości wypadków złe sąsiedztwo na współdzielonym hostingu nie jest szczególnie wielkim problemem.

DNS Anycast

DNS Anycast może sprawić, że DNS Lookup Time, czyli czas oczekiwania na odpowiedź z serwera DNS będzie nawet o 100 ms krótszy. W takim wypadku krótsze będzie także TTFB, co zdaniem wielu specjalistów – sprzyja osiąganiu lepszych pozycji.

TTFB będzie na koniec rzutować na metryki Core Web Vitals, bo np. trudno, żeby czas wczytywania największego elementu strony, LCP, był atrakcyjny, kiedy czas do pierwszego bajtu jest bardzo długi.

DNS Anycast to także bezpieczeństwo – system z centralnymi serwerami DNS jest bardziej podatny na awarię, a awaria na poziomie DNS może oznaczać zniknięcie całej domeny z sieci. Ma to swoje odbicie w – na szczęście przejściowym – spadku z pozycji, a także negatywnie rzutuje na indeksowanie. Jeśli czekasz na zaindeksowanie nowej domeny, a ona wciąż się nie pojawia w indeksie i wreszcie robot Cię odwiedza, a strona wówczas nie działa… – chyba sam rozumiesz.

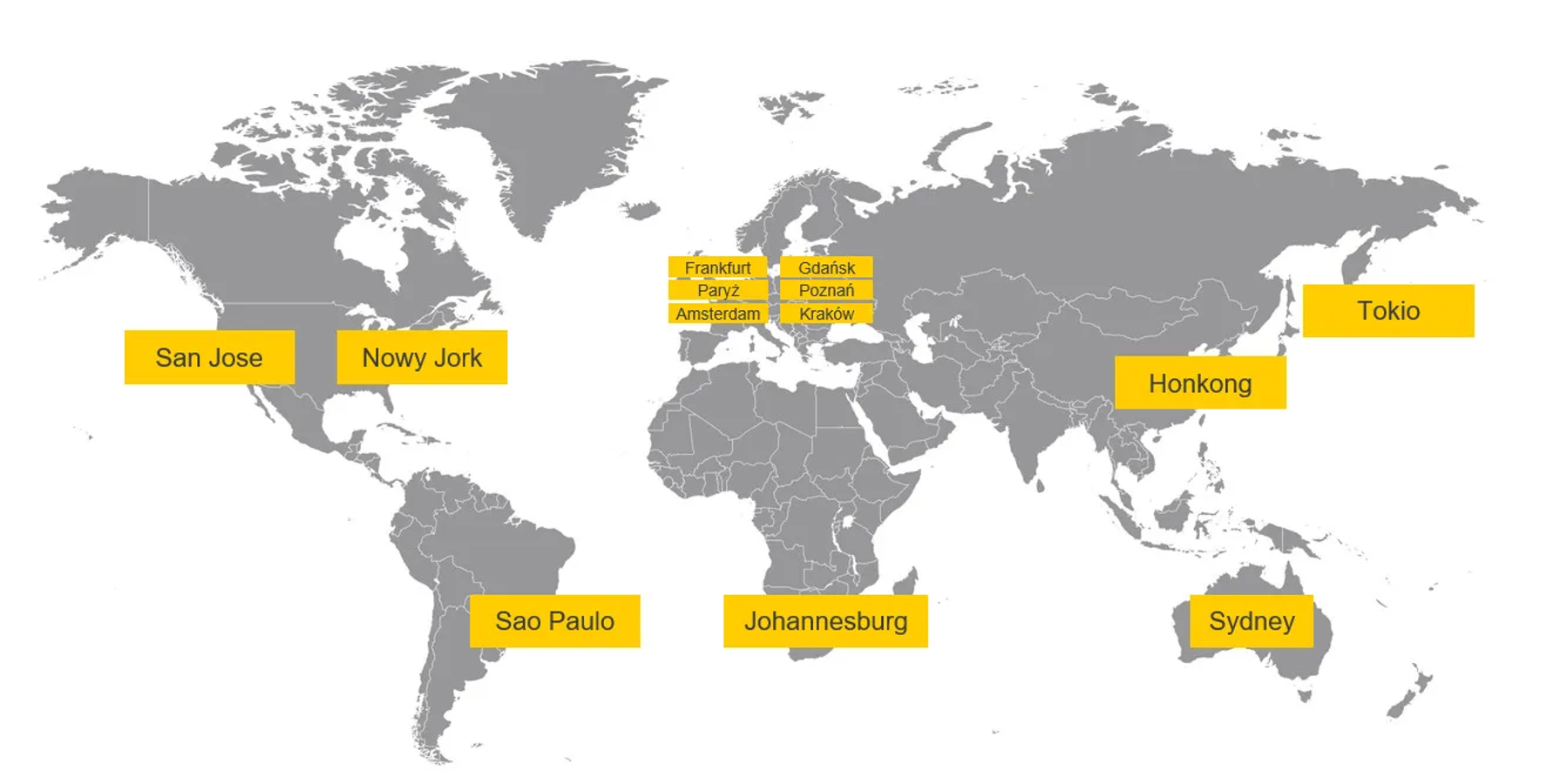

Mapa serwerów DNS Anycast (źródło: cyberfolks.pl)

Mając wybór – lepiej wybierać hostingi, które wspierają technologię DNS Anycast. Jest to szczególnie istotne, kiedy masz użytkowników fizycznie daleko od serwera. uzyskujesz wtedy korzyść w warstwie domeny, którą można częściowo przyrównać do CDN w warstwie zasobów www.

Geolokalizacja

Wreszcie temat-rzeka, czyli geolokalizacja serwera. Kiedy serwer jest na drugim końcu świata, to ze względu na takie ograniczenia, jak prędkość światła w próżni – a w zasadzie – w światłowodzie – pojawiają się opóźnienia w komunikacji między przeglądarką i serwerem.

Przyjmując 5 tys. km odległości – samo pokonanie takiej drogi w czystym światłowodzie zajmuje sygnałowi ok. 25 ms w jedną stronę. To sprawia, że technologie redukujące liczbę żądań do serwera stają się ważne. Do kluczowych spraw należą tutaj nowoczesne protokoły HTTP/2, HTTP/3, dzięki którym komunikacja staje się efektywna.

Dziś większość hostingów je obsługuje, tylko pamiętaj, że zestawienie połączeń w tym trybie wymaga szyfrowania HTTPS, a więc musisz mieć zainstalowany certyfikat SSL.

Wiadomo, że w oparciu o bazy geoIP można oszacować fizyczną lokalizację serwera na podstawie jego adresu IP. Część wyników wyszukiwania, jakie widzimy w przeglądarce, odnosi się do lokalizacji pytającego. Użytkownik w Gdyni wcale nie musi uzyskać identycznych wyników dla danego słowa, jak użytkownik w Berlinie, choć tu poza lokalizacją dochodzą jeszcze wersje językowe.

Zdania specjalistów są tu podzielone. Z jednej strony miałem okazję obsługiwać klienta, który koniecznie klaster serwerów dedykowanych z dużym sklepem internetowym chciał mieć w Berlinie, ponieważ wskazywał, że dzięki temu uzyskuje lepsze pozycje w google.de – a na tym mu bardzo zależało. Z drugiej strony spotkałem specjalistów seo, którzy przenosili strony między krajami i nie widzieli żadnego wpływu na realnie osiągane pozycje.

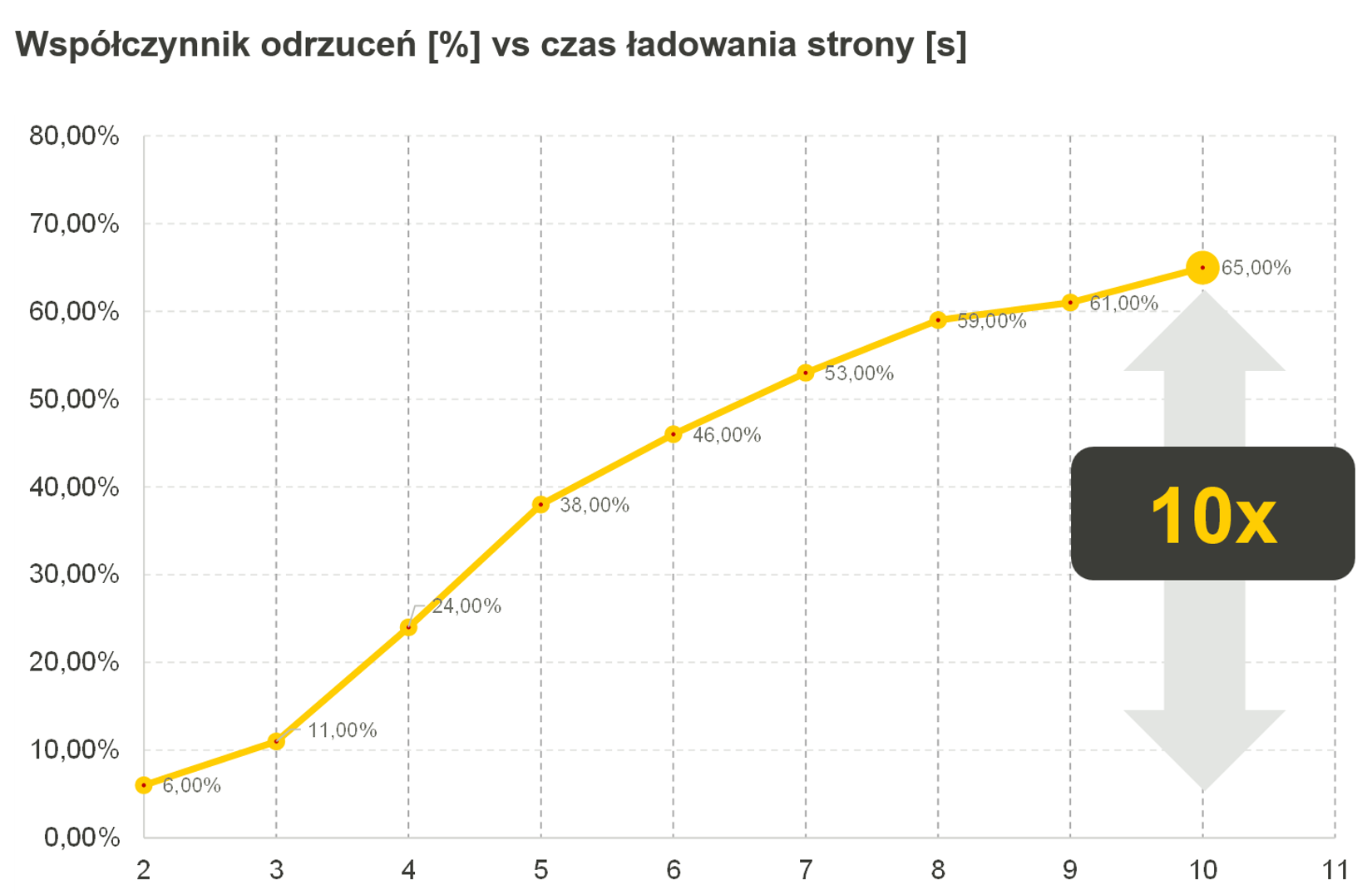

Pamiętaj, że poza czystą pozycją w SERP istnieją tu też pewne korzyści z przyspieszonego wczytywania strony, kiedy mówimy o przybliżaniu serwera do użytkownika. Istnieje mnóstwo badań potwierdzających, że z punktu widzenia doświadczenia użytkownika – ludzie wolą szybsze strony. Badania Pingdom mówią o tym, że wydłużanie czasu wczytywania strony radykalnie pogarsza bounce rate, czyli współczynnik odrzuceń.

Wykres przedstawiający wpływ czasu ładowania na współczynnik odrzuceń (źródło: pingdom.com)

Mówiąc o geolokalizacji pamiętaj też o tym, że czasami może zajść konieczność skorzystania z supportu firmy hostingowej. W takim wypadku dobrze jest mieć pewność, że się dogadamy, a także tego, że ktoś po drugiej stronie pracuje – uwzględniając różnice stref czasowych.

Geolokalizacja może wpływać na kształtowanie wyników SERP zwłaszcza dla fraz z mocnym kontekstem lokalnym. Dla wszelkich fraz spływa natomiast na takie zagadnienia, jak szybkość wczytywania czy czasy reakcji firmy hostingowej.

Poufność

Poufność rozumiana jest jako szyfrowanie komunikacji między serwerem i przeglądarką, co w praktyce jest realizowane dzięki protokołowi HTTPS opartemu o certyfikat SSL i asymetryczne metody kryptograficzne.

W skrócie – chodzi o to, że certyfikat SSL szyfruje dane jeszcze w przeglądarce użytkownika i one są przesyłane na serwer w postaci zaszyfrowanej. Jeszcze przed 2020 i oficjalnym ogłoszeniem czynników jakości strony, Niel Patell badał korelację między pozycjami stron a certyfikatami SSL.

Wykres przedstawiający odsetek stron z certyfikatem SSL i jego wpływ na pozycję w Google (źródło: neilpatel.com)

Warto zwrócić uwagę, że korelacja nie oznacza kauzacji i trudno tu wykluczyć, że ci, którzy mieli certyfikat SSL jednocześnie nie zadbali mocniej o inne cechy strony – szybkość, treści, strukturę, tytuł, semantykę itp.

Obecnie jednak uważam, że ponieważ Google mówi o tym wprost w oficjalnych materiałach, a przeglądarki wyświetlają ostrzeżenia przed interakcjami ze stronami niezabezpieczonymi w ten sposób – dziś SSL to bezdyskusyjna podstawa.

Z punktu widzenia SEO prawdopodobnie wystarczy Ci darmowy Let’s Encrypt – upewnij się, że hosting w pełni go wspiera i nie wymaga ukrytych opłat. Jednak z punktu widzenia wiarygodności strony – w wielu wypadkach inwestycja w komercyjny SSL może okazać się całkiem rozsądnym posunięciem, zwłaszcza na poziomie walidacji OV/EV.

Bezpieczeństwo

Google odnosi się wprost do zagadnień bezpieczeństwa. Wg statystyk, jakie w cyberfolks.pl uzyskujemy z systemów ochraniających strony wynika, że strona w Polsce średnio jest atakowana 6.000 rocznie! A przecież wystarczy, że jeden atak się powiedzie…

A co, jeśli się powiedzie? No właśnie, Google przewiduje w takich wypadkach cały katalog kar.

Przyczyny oznaczania i usuwania treści z SERP-ów Google (źródło: Google)

Jednym słowem, jeśli nie chcesz bliżej poznawać w praktyce tych zasad:

- dbaj o aktualne wersje swojego CMS;

- sprawdzaj aktualność wtyczek i motywów;

- nie instaluj oprogramowania z “dziwnych” źródeł na swoim serwerze;

- stosuj zapory filtrujące ruch;

Dobry hosting zazwyczaj zapewnia klientom mechanizmy obronne. W cyberfolks.pl zbudowaliśmy WAF’a, który chroni przed spamowaniem, mogącym prowadzić do kar, ale przede wszystkim do “rozwodnienia” treści Twojej strony i powstania niechcianych linków wychodzących. WAF obniża też ryzyko ataków typu SQL Injection czy XSS.

Większość osób ma prawo w tym momencie spytać: ale hej, przecież filtrowanie ruchu opóźnia wczytywanie strony, bo to są dodatkowe czynności, czy na pewno warto, skoro szybkość jest taka ważna?

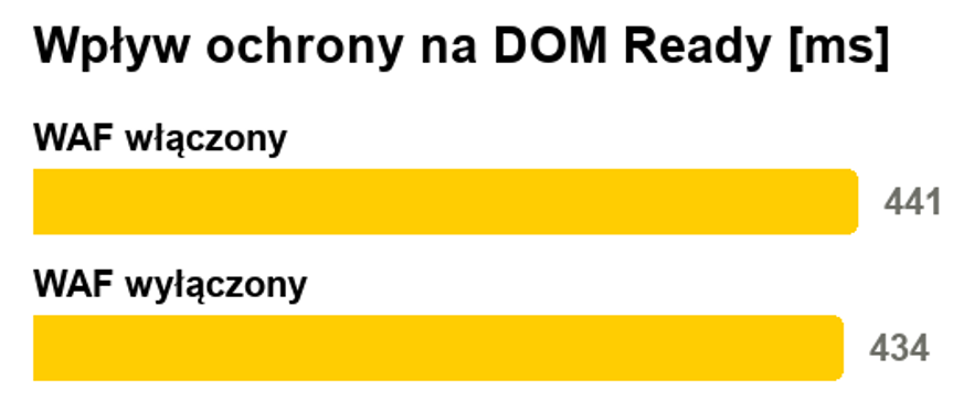

Ja również zadawałem sobie to pytanie i żebyś Ty nie musiał/a – zmierzyłem czas wczytywania sklepu z włączoną i wyłączoną ochroną*, posiłkując się dostępną pod F12 miarą DOM Ready mówiącą o czasie przygotowania drzewa dokumentu strony:

Wpływ ochrony WAF na DOM Ready (źródło: cyberfolks.pl)

*Wordpress 5.8 + WooCommerce 6.0.0 + StoreFront, LS Cache włączone

Jak widzisz, ochrona WAF owszem, spowalnia wczytywanie, ale mówimy tu o ok. 10 ms (tysięcznych częściach sekundy). Dla porównania: mrugnięcie ludzkiego oka to ok. 200-300 ms.

W zamian zyskujesz ochronę przed spamowaniem przez formularze, próbami brute-force, sql injection czy xss, czyli znaczne obniżenie ryzyka, że strona zostanie zainfekowana złośliwym oprogramowaniem czy spamerskimi linkami.

Odpowiedź na pytanie: czy warto? – pozostawiam Tobie. A może podzielisz się nią w komentarzu? Daj znać poniżej, co z tego artykułu jest dla Ciebie najbardziej interesujące, a jeśli masz do mnie pytania – zapraszam do kontaktu przez LinkedIn.

Artur Pajkert

Poszukujesz agencji SEO w celu wypozycjonowania swojego serwisu? Skontaktujmy się!