Wyobraź sobie, że wszystkie Twoje urządzenia komunikują się ze sobą tak płynnie, jakby używały jednego, uniwersalnego kabla. Właśnie taką rolę w świecie sztucznej inteligencji ma odegrać Model Context Protocol (MCP). To otwarty standard, który Anthropic wprowadziło w listopadzie 2024 roku. Jego głównym zadaniem jest uporządkowanie sposobu, w jaki Duże Modele Językowe (LLM) i aplikacje AI łączą się z narzędziami, danymi i systemami zewnętrznymi. Protokół ten chce raz na zawsze rozwiązać problem chaotycznych, fragmentarycznych integracji, stając się czymś w rodzaju „USB-C dla AI”. Zaraz zobaczysz, czym dokładnie jest MCP, dlaczego jest tak istotny dla przyszłości AI i jak może całkowicie odmienić interakcje sztucznej inteligencji z otaczającym światem.

Co to w ogóle jest Model Context Protocol (MCP)?

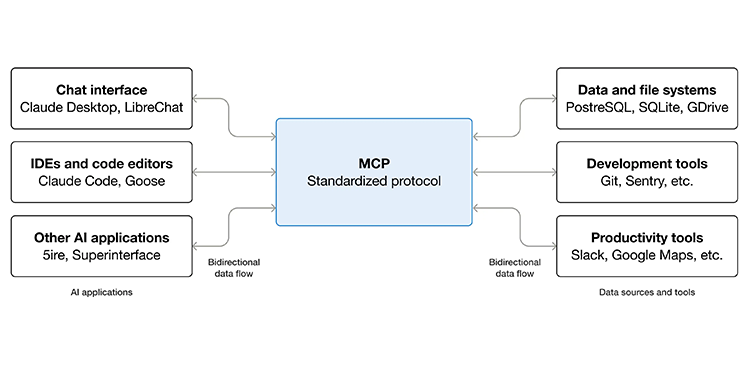

Model Context Protocol (MCP) to nie tylko otwarty standard, ale i kompletna struktura, która zapewnia uniwersalny, jednolity sposób komunikacji dla każdej sztucznej inteligencji. Tworzy on dwukierunkową warstwę, która umożliwia modelom AI dostęp do danych w czasie rzeczywistym i wykonywanie różnych funkcji. I co ważne, wszystko to dzieje się bez potrzeby tworzenia za każdym razem od nowa specjalnych łączników dla każdej integracji. Ten standard zmienia skomplikowany problem integracji „M×N” (gdzie M to modele, a N to narzędzia) w znacznie prostszy układ „M+N”. Dzięki temu zarówno aplikacje, jak i agenci AI mogą bez problemu rozmawiać z zewnętrznymi narzędziami i bazami danych.

MCP to coś więcej niż protokół; to dowód na to, jak bardzo potrzebowaliśmy ujednolicić interakcje AI ze światem. Bez niego rozwój inteligentnych systemów oznaczałby wieczną walkę z niestandardowymi API, co hamowałoby innowacje.

Ten protokół działa jak wspólny język. Dzięki niemu modele AI mogą rozumieć i korzystać z możliwości, jakie oferują im rozmaite systemy zewnętrzne. Coś, co wcześniej było skomplikowanym labiryntem API każdego narzędzia, teraz staje się proste, a to bardzo przyspiesza tworzenie i wdrażanie zaawansowanych aplikacji opartych na sztucznej inteligencji.

Podstawy architektury MCP: Czyli jak to właściwie działa?

Architektura Model Context Protocol (MCP) opiera się na prostym, ale elastycznym modelu klient-serwer. Składa się z kilku ważnych elementów, które współpracują ze sobą, żeby integracja AI przebiegała gładko. Ta architektura to tak naprawdę fundament całego protokołu.

Oto jak wygląda podział ról w MCP:

| Komponent | Opis |

|---|---|

| Host Application | To środowisko, w którym znajdują się albo które koordynuje Duże Modele Językowe (LLM). Działa jak główny „dyrygent” AI. Zarządza cyklem życia klienta, autoryzacją i zbiera kontekst, co gwarantuje, że cały system działa spójnie i bezpiecznie. |

| MCP Clients | Są częścią aplikacji hosta. Działają jak interfejsy komunikacyjne, utrzymując odizolowane, stanowe połączenia z serwerami MCP. Odpowiadają za przekazywanie wiadomości, negocjacje protokołów i pilnowanie zasad bezpieczeństwa i prywatności. |

| MCP Servers | To niezależne usługi, które dostarczają aplikacjom AI konkretne dane, narzędzia zewnętrzne albo funkcje. Ich niezależność pozwala na bardzo elastyczne wdrażanie, czego dowodem jest ponad 5 000 publicznych serwerów MCP działających na całym świecie. |

| Transport Layer | To „kręgosłup” komunikacji, czyli mechanizm, który pozwala klientom i serwerom wymieniać dane. Wykorzystuje STDIO do połączeń lokalnych oraz HTTP + Server-Sent Events (SSE) do komunikacji zdalnej. Wszystkie komunikaty przesyłane są w formacie JSON-RPC 2.0. |

| Security and Privacy Mechanisms | To solidny zestaw zabezpieczeń, które chronią interakcje AI. Protokół używa standardów uwierzytelniania i autoryzacji, takich jak JSON Web Token (JWT), OpenID Connect (OIDC) i OAuth 2.1, żeby bezpiecznie i zgodnie z polityką firmy udostępniać wrażliwe dane. |

Warstwa transportowa: Kręgosłup komunikacji

Warstwa transportowa Model Context Protocol (MCP) to tak naprawdę podstawa, która umożliwia wymianę danych między klientami a serwerami. Wykorzystuje dwa główne mechanizmy: STDIO do połączeń lokalnych oraz HTTP + Server-Sent Events (SSE) do komunikacji zdalnej. Pamiętaj, że wszystkie komunikaty przesyłane są w ustandaryzowanym formacie JSON-RPC 2.0, co gwarantuje, że wszystko działa spójnie i jest łatwe w integracji.

Mechanizmy bezpieczeństwa i prywatności: Jak chronić Twoje interakcje AI?

Model Context Protocol (MCP) naprawdę stawia na bezpieczeństwo. Stosuje niezawodne mechanizmy, które chronią interakcje AI. Żeby zapewnić bezpieczny i zgodny z polityką dostęp do wrażliwych danych korporacyjnych, protokół wykorzystuje standardy uwierzytelniania i autoryzacji, takie jak JSON Web Token (JWT), OpenID Connect (OIDC) oraz OAuth 2.1. Te rozwiązania są niezbędne do ochrony Twoich danych i budowania zaufania użytkowników.

Jakie korzyści przynosi wdrożenie MCP?

Wdrożenie Model Context Protocol (MCP) ma naprawdę przemyślane cele i przynosi konkretne korzyści, które mocno wpływają na rozwój i wykorzystanie sztucznej inteligencji. Ten protokół to odpowiedź na coraz większą potrzebę standardowej i bezpiecznej integracji narzędzi AI.

Ujednolicenie integracji AI: Jak MCP rozwiązuje problem fragmentacji?

Głównym celem MCP jest ujednolicenie integracji AI. Zastępuje on te wszystkie fragmentaryczne, tworzone na miarę integracje API jednym, spójnym protokołem. To niesamowicie upraszcza komunikację dla systemów AI i narzędzi biznesowych. Zmniejsza również złożoność, która często towarzyszy wdrażaniu AI w firmach. Dzięki temu deweloperzy mogą tworzyć bardziej spójne i łatwiejsze w zarządzaniu rozwiązania.

Większe możliwości AI i głębsze zrozumienie kontekstu: Jak MCP wzbogaca sztuczną inteligencję?

MCP wzmacnia możliwości AI, dając jej dynamiczny i zawsze aktualny dostęp do zewnętrznej wiedzy i funkcji, wychodząc poza statyczne dane, na których model był trenowany. To przynosi kilka namacalnych korzyści dla sztucznej inteligencji:

- modele AI mają dostęp do aktualnych danych, co pozwala im na trafniejsze wnioskowanie,

- skuteczne zarządzanie kontekstem minimalizuje powielanie pracy, co oszczędza czas i zasoby,

- AI dostarcza odpowiedzi, które dokładnie odzwierciedlają bieżącą sytuację,

- AI płynniej przełącza się między różnymi źródłami danych i zadaniami.

Wspieranie interoperacyjności ekosystemu: Jak MCP buduje spójną infrastrukturę AI?

MCP aktywnie działa na rzecz interoperacyjności całego ekosystemu. Umożliwia dostawcom narzędzi i deweloperom AI tworzenie serwerów i klientów MCP, które są uniwersalnie kompatybilne. To sprzyja modułowej infrastrukturze AI, gdzie różne komponenty mogą bez problemu ze sobą współpracować, co z kolei zwiększa elastyczność i skalowalność systemów. Dzięki temu tworzenie nowych aplikacji AI staje się szybsze i bardziej efektywne.

Bezpieczeństwo przy rozszerzonym dostępie: Jak MCP równoważy dostępność z ochroną?

MCP dba o to, żeby Twoje modele AI mogły bezpiecznie uzyskiwać dostęp do wrażliwych danych i operacji. Równocześnie protokół bardzo dokładnie przestrzega korporacyjnych polityk bezpieczeństwa i prywatności użytkowników. Te mechanizmy bezpieczeństwa i prywatności są niezastąpione w biznesie, gdzie ochrona danych to absolutny priorytet.

Większa produktywność deweloperów i skalowalność: Jak MCP optymalizuje rozwój AI?

MCP przyczynia się do zwiększenia produktywności deweloperów i skalowalności architektury, oferując komponenty kodu, które możesz wykorzystać wielokrotnie, oraz uniwersalny standard komunikacji. To wyraźnie skraca czas potrzebny na rozwój i obniża koszty utrzymania. Jest to szczególnie istotne w szybko zmieniającym się świecie sztucznej inteligencji, gdzie efektywność ma ogromne znaczenie.

Główne zastosowania i przypadki użycia MCP

Model Context Protocol (MCP) świetnie sprawdza się w wielu praktycznych zastosowaniach. Możesz zobaczyć jego wartość w różnych branżach, bo obejmuje naprawdę szeroki zakres integracji i automatyzacji AI.

Integracje AI i interoperacyjność: Jak MCP łączy modele z systemami?

Integracje AI i interoperacyjność pozwalają modelom AI bezproblemowo komunikować się z bazami danych, API, przeglądarkami oraz wewnętrznymi systemami korporacyjnymi. Protokół ten skutecznie rozwiąże złożony problem integracji typu „M×N”, upraszczając proces łączenia różnych komponentów AI ze źródłami danych i zewnętrznymi narzędziami.

Chatboty AI i konwersacyjna AI: Jak MCP usprawnia interakcje?

Chatboty AI i konwersacyjna AI używają MCP do prowadzenia złożonych rozmów, jednocześnie pamiętając kontekst z poprzednich sesji. Dzięki temu obsługa klienta i ogólne wrażenia użytkownika są dużo lepsze, bo agenci AI mogą pamiętać Twoje wcześniejsze preferencje czy historię interakcji.

Automatyzacja i przepływy pracy oparte na AI: Jak MCP napędza wydajność?

Automatyzacja i przepływy pracy oparte na AI integrują się z zewnętrznymi narzędziami i źródłami danych za pośrednictwem MCP, aby zautomatyzować złożone procesy. Czy to w finansach, opiece zdrowotnej, czy produkcji – zwiększa to efektywność i zmniejsza liczbę błędów, ponieważ agenci AI mogą koordynować skomplikowane zadania.

Spersonalizowane działania i tworzenie treści: Jak MCP dostosowuje komunikację?

Spersonalizowane działania i tworzenie treści to kolejna duża zaleta. Pomyśl o automatyzacji spersonalizowanych kampanii cold outreach: MCP pozwala łączyć się z bazami danych, wyszukiwać adresy e-mail i generować dostosowane dokumenty – a wszystko to pod kontrolą agentów AI.

Międzyplatformowe aplikacje AI: Jak MCP zapewnia spójność?

Międzyplatformowe aplikacje AI działają dzięki MCP w spójny sposób, zapewniając płynne przenoszenie kontekstu między użytkownikami. Nieważne, czy korzystasz z sieci, telefonu, interfejsu głosowego czy czegoś innego – Twoje doświadczenie pozostaje jednolite.

MCP w prawdziwym świecie: Statystyki i wpływ na adopcję

Od momentu wprowadzenia przez Anthropic, Model Context Protocol (MCP) zyskuje na popularności w niezwykłym tempie i ma ogromny wpływ na cały ekosystem AI. Poniższe liczby i przykłady dobrze pokazują, jak bardzo rośnie jego znaczenie.

Szybka i szeroka adopcja: Jak MCP stał się standardem?

MCP szybko stał się powszechnym standardem dla integracji narzędzi AI, często nazywanym „USB-C dla AI”. Na świecie wdrożono już ponad 5 000 publicznych serwerów MCP, co wyraźnie świadczy o jego szerokim zastosowaniu. Protokół przyjęli też czołowi gracze technologiczni, co jeszcze bardziej umacnia jego pozycję.

Poparcie dużych dostawców technologii: Kto wspiera MCP?

Giganci technologiczni, tacy jak Microsoft, OpenAI, Google, AWS i Cloudflare, przyjęli MCP. To poparcie ze strony tak dużych firm jasno pokazuje, że rynek mocno wierzy w Model Context Protocol (MCP) jako rozwiązanie przyszłości. Ich zaangażowanie potwierdza, że MCP jest postrzegany jako centralny element infrastruktury AI.

Duże zaangażowanie deweloperów: Jak MCP przyciąga społeczność?

Zainteresowanie deweloperów jest ogromne, o czym świadczą statystyki: miesięczna liczba pobrań MCP Python SDK przekracza 6,6 miliona, a repozytoria MCP na GitHubie mają łącznie ponad 50 000 gwiazdek. Te liczby pokazują, jak aktywna jest społeczność open-source, która dynamicznie rozwija i wspiera protokół.

Penetracja w przedsiębiorstwach i wzrost rynku: Jakie są prognozy dla MCP?

Przewiduje się, że do 2025 roku aż 90% organizacji przyjmie MCP, co podkreśla jego rolę w zapewnieniu interoperacyjności AI. Rynek MCP ma wzrosnąć z 1,3 miliarda dolarów w 2022 roku do 13,4 miliarda dolarów do 2027 roku. Ten duży wzrost wynika z coraz większej potrzeby łączenia modeli AI z danymi w czasie rzeczywistym.

Adopcja MCP jest niezwykła, pokazuje, jak bardzo branża potrzebowała spójnego standardu. To zmienia sposób, w jaki myślimy o integracji AI w każdym sektorze.

Wyzwania i przyszłe perspektywy Model Context Protocol (MCP)

Mimo wielu zalet, Model Context Protocol (MCP) staje przed pewnymi wyzwaniami i złożonościami, które wymagają naszej uwagi. Jednocześnie eksperci przewidują, że ten protokół ma przed sobą dynamiczną przyszłość i stanie się centralnym elementem infrastruktury AI.

Luka bezpieczeństwa w integracji AI: Jakie są zagrożenia?

Musimy pamiętać o pewnych ryzykach. Krytyczne zagrożenia bezpieczeństwa to tak zwane „ataki zatrucia narzędzi” (Tool Poisoning Attacks). Złośliwi aktorzy mogą wstrzyknąć szkodliwe instrukcje do kontekstu, który rozumie agent AI, co może doprowadzić do wycieku danych albo błędnych działań. To wymaga od nas stałej czujności i rozbudowanych mechanizmów obronnych.

Złożoność uwierzytelniania i autoryzacji: Jakie są wyzwania?

Wyzwania związane z uwierzytelnianiem i autoryzacją są spore. Model Context Protocol (MCP) do zdalnego dostępu do serwerów wykorzystuje OAuth 2.1, co wiąże się ze skomplikowanym zarządzaniem tożsamością w rozproszonych środowiskach. Skuteczne radzenie sobie z tymi procesami jest absolutnie niezbędne, żeby system zachował swoją integralność.

Niezbędny nadzór człowieka: Dlaczego człowiek musi czuwać nad AI?

Mimo całej automatyzacji, obecność człowieka i jego nadzór pozostają nieodzowne. Nieprawidłowe konfiguracje we wdrożeniach MCP mogą prowadzić do niepożądanych zachowań AI z powodu problemów z bezpieczeństwem i zaufaniem. Ludzki nadzór pomaga zapobiegać nieprzewidzianym konsekwencjom i reagować na nie.

Wyzwania skalowania i architektury: Jak MCP radzi sobie z rozwojem?

Wyzwania skalowania i architektury dotyczą odporności systemu i komfortu pracy deweloperów. Przenoszenie serwerów MCP do zdalnych, rozproszonych i multicloudowych konfiguracji stwarza nowe problemy, które trzeba rozwiązać, żeby zapewnić stabilność i wydajność w miarę wzrostu.

Przyszłość MCP: Co czeka protokół?

Eksperci są zgodni, że Model Context Protocol (MCP) będzie się rozwijał jako podstawowy komponent infrastruktury AI. Ciągłe ulepszenia w zakresie bezpieczeństwa, wykrywania usług i narzędzi pozwolą na szersze przyjęcie zaawansowanych agentów AI, co doprowadzi do powstania jeszcze inteligentniejszych i lepiej zintegrowanych systemów.

MCP kontra inne protokoły: Co czyni go tak wyjątkowym?

Model Context Protocol (MCP) wyróżnia się na tle innych protokołów i frameworków, bo jest model-agnostycznym, otwartym standardem, stworzonym specjalnie do dynamicznej integracji między Dużymi Modelami Językowymi (LLM) a zewnętrznymi narzędziami. Jego wyjątkowość polega na tym, jak rozwiązuje problem fragmentacji w integracji narzędzi AI.

Co go odróżnia? MCP nie jest związany z jednym dostawcą ani konkretnym modelem AI, w przeciwieństwie do rozwiązań specyficznych dla firm, takich jak OpenAI’s function-calling API czy wtyczki ChatGPT. I to właśnie jest jego duża zaleta, bo pozwala na dużo szerszą interoperacyjność. Protokół czerpał inspirację z Language Server Protocol (LSP), ale został przystosowany do kontekstów AI, a nie tylko do narzędzi dla programistów.

MCP pozwala na dynamiczne wykrywanie możliwości w czasie rzeczywistym, co eliminuje potrzebę stosowania sztywno zakodowanej logiki. Dostępność otwartych SDK w wielu językach, takich jak Python, TypeScript, Java i C#, bardzo ułatwia wdrożenie i rozwój. Ostatecznie, MCP radzi sobie z problemem fragmentacji, łącząc rozproszone integracje narzędzi AI pod jednym, spójnym dachem.

Model Context Protocol (MCP): Dlaczego jest tak ważny dla przyszłości AI?

Model Context Protocol (MCP) to rewolucyjny, uniwersalny, otwarty i bezpieczny standard dla integracji narzędzi AI. To, że Anthropic go wprowadziło, naprawdę zmienia sposób, w jaki Duże Modele Językowe (LLM) i aplikacje AI współpracują z otaczającym światem. Wśród głównych korzyści znajdziesz zwiększone możliwości AI, lepszą interoperacyjność i usprawniony proces rozwoju.

Model Context Protocol (MCP) to solidny fundament pod budowę kolejnej generacji inteligentnych, świadomych kontekstu aplikacji AI. Daje AI dostęp do danych w czasie rzeczywistym i pozwala wykorzystywać różnorodne narzędzia, co przekłada się na trafniejsze, spójniejsze i bardziej użyteczne rozwiązania. Właśnie dzięki MCP sztuczna inteligencja może stać się prawdziwie zintegrowaną i wszechstronną częścią naszego cyfrowego ekosystemu.

Zachęcam Cię do sprawdzenia, jak MCP może odmienić Twoje integracje AI i wzbogacić Twoje LLM o dane kontekstowe w czasie rzeczywistym. Odwiedź dokumentację Anthropic MCP i zacznij działać już dziś!

FAQ – najczęściej zadawane pytania o Model Context Protocol (MCP)

Kto stworzył Model Context Protocol (MCP) i kiedy został on zaprezentowany?

Model Context Protocol (MCP) został zaprezentowany przez firmę Anthropic w listopadzie 2024 roku.

Jak MCP usprawnia działanie sztucznej inteligencji?

MCP wzmacnia możliwości AI, ponieważ Duże Modele Językowe (LLM) mogą dzięki niemu uzyskiwać dostęp do aktualnych, zewnętrznych źródeł danych i narzędzi w czasie rzeczywistym. To daje im głębsze zrozumienie kontekstu, znacznie wykraczające poza statyczne dane treningowe. W efekcie AI dostarcza trafniejsze i bardziej spójne odpowiedzi, a także lepiej radzi sobie z „podatkiem od zmiany kontekstu”.

Co oznacza porównanie „USB-C dla AI” w kontekście MCP?

Porównanie „USB-C dla AI” podkreśla rolę MCP w standaryzacji integracji narzędzi AI w różnych systemach. Tak jak USB-C jest uniwersalnym złączem dla wielu urządzeń, tak MCP upraszcza łączność i interoperacyjność w świecie sztucznej inteligencji.

Z jakich elementów składa się architektura MCP?

Podstawowa architektura klient-serwer MCP składa się z aplikacji hosta (Host Application), klientów MCP (MCP Clients), serwerów MCP (MCP Servers) oraz warstwy transportowej (Transport Layer). Komunikacja odbywa się w ustandaryzowanym formacie JSON-RPC 2.0.

Jakie są obawy związane z bezpieczeństwem MCP?

Główne obawy dotyczące bezpieczeństwa to „ataki zatrucia narzędzi” (Tool Poisoning Attacks), gdzie złośliwe instrukcje mogą zostać wstrzyknięte, oraz złożoność uwierzytelniania i autoryzacji w rozproszonych systemach, które wykorzystują protokoły takie jak OAuth 2.1. Niezmiennie ważna jest tu również potrzeba nadzoru ze strony człowieka.

Czym MCP różni się od funkcji wywoływania OpenAI?

Chociaż oba rozwiązania pozwalają AI na interakcję z narzędziami, MCP to otwarty standard i protokół. Jest model-agnostyczny i neutralny wobec dostawców, a OpenAI’s function-calling API to autorskie rozwiązanie, stworzone specjalnie dla modeli OpenAI. MCP dąży do uniwersalnej interoperacyjności między dowolnymi zgodnymi modelami AI i zewnętrznymi narzędziami.

Poszukujesz agencji SEO w celu wypozycjonowania swojego serwisu? Skontaktujmy się!

Paweł Cengiel

Cechuję się holistycznym podejściem do SEO, tworzę i wdrażam kompleksowe strategie, które odpowiadają na konkretne potrzeby biznesowe. W pracy stawiam na SEO oparte na danych (Data-Driven SEO), jakość i odpowiedzialność. Największą satysfakcję daje mi dobrze wykonane zadanie i widoczny postęp – to jest mój „drive”.

Wykorzystuję narzędzia oparte na sztucznej inteligencji w procesie analizy, planowania i optymalizacji działań SEO. Z każdym dniem AI wspiera mnie w coraz większej liczbie wykonywanych czynności i tym samym zwiększa moją skuteczność.