Zarządzanie Crawl Budget to podstawa Twojej strategii SEO, zwłaszcza jeśli masz dużą stronę z tysiącami, a nawet milionami podstron. To, jak mądrze wykorzystasz budżet indeksowania, zdecyduje, czy Googlebot sprawnie znajdzie, przetworzy i zaindeksuje Twoje najważniejsze treści. A to przecież bezpośrednio wpłynie na ich widoczność w wyszukiwarce! Przy rozbudowanych serwisach, gdzie zasoby indeksowania są z natury ograniczone, strategiczna optymalizacja budżetu indeksowania jest po prostu niezbędna, żeby Twoje treści szybciej pojawiały się w Google i żebyś mógł konkurować na rynku. W tym artykule wyjaśnię Ci, czym właściwie jest Crawl Budget. Pokażę Ci też zaawansowane strategie – takie jak priorytetyzacja, czyszczenie treści (content pruning) i sitemapy tematyczne – dzięki którym poradzisz sobie z indeksacją nawet bardzo dużej strony.

Podstawy Crawl Budget: co to jest i dlaczego ma znaczenie dla dużych serwisów?

Crawl Budget to ograniczona liczba stron, które Googlebot może i chce odwiedzić na Twojej witrynie w danym czasie. Pomyśl tylko, to ma ogromne znaczenie dla dużych stron! Niewłaściwe zarządzanie tym budżetem może sprawić, że Twoje kluczowe treści nigdy się nie zaindeksują albo będą aktualizowane z dużym opóźnieniem.

Jakie są główne elementy Crawl Budget: Crawl Rate Limit i Crawl Demand?

Główne elementy Crawl Budget to Crawl Rate Limit i Crawl Demand. Razem decydują one, ile zasobów Googlebot przeznaczy na skanowanie Twojej witryny:

- Crawl Rate Limit to maksymalna liczba zapytań, które robot wyszukiwarki może wysłać do Twojego serwera w określonym czasie. Na jego wysokość wpływa prędkość strony (Page Speed) i stabilność serwera (Server Stability). Powolne serwery lub długi czas ładowania stron automatycznie obniżają ten limit, żeby ochronić serwer przed przeciążeniem.

- Crawl Demand z kolei odzwierciedla zapotrzebowanie wyszukiwarki na przeszukiwanie Twojej strony. Determinują je popularność strony (Website Popularity), ilość treści (Content Quantity) i częstotliwość aktualizacji (Content Update Frequency). Im bardziej Twoja strona jest popularna i dynamiczna, tym większe jest jej postrzegane zapotrzebowanie na indeksację.

Według Google, Crawl Rate Limit ustawia się w Google Search Console. Możesz go dostosować, ale rzadko kiedy jest to zalecane.

Jakie czynniki wpływają na Crawl Budget i jego efektywność?

Na Crawl Budget i jego efektywność wpływa wiele czynników, które sygnalizują wyszukiwarkom, jak wartościowa jest Twoja strona. Pomaga to Googlebotowi efektywniej alokować swoje zasoby. Do najważniejszych należy autorytet domeny (Domain Authority), czyli ogólna siła i potencjał rankingowy witryny, co często przekłada się na większy budżet indeksowania. Równie istotna jest jakość i unikalność treści (Content Quality), bo wyszukiwarki wolą oryginalne i wartościowe informacje, poświęcając mniej czasu na duplikaty. Ponadto, dobrze zorganizowana struktura strony (Site Structure) i przemyślane linkowanie wewnętrzne (Internal Linking Improvement) sprawiają, że roboty mogą szybko i efektywnie poruszać się między podstronami. Nie możesz zapomnieć o szybkości ładowania strony (Page Loading Speed), ponieważ szybka strona zużywa mniej zasobów serwera i pozwala zaindeksować więcej podstron w tym samym czasie.

Dlaczego optymalizacja Crawl Budget jest tak ważna dla dużych serwisów?

Optymalizacja Crawl Budget jest niezwykle ważna dla dużych stron, bo przecież zasoby Googlebot są ograniczone, a stron do przetworzenia masz ogromną liczbę. Jeśli roboty tracą czas na indeksowanie stron niskiej jakości, powielonych, błędnych lub wolno ładujących się, wartościowe nowe treści mogą być odwiedzane rzadziej albo wcale. Taki scenariusz bezpośrednio wpływa na szybkość indeksowania (Faster Indexing) nowych i zmienionych treści, a także źle działa na widoczność (Improved SERP Visibility) Twoich kluczowych podstron w wynikach wyszukiwania. W efekcie nieoptymalne zarządzanie budżetem indeksowania może doprowadzić do utraty widoczności i obniżenia pozycji w organicznych wynikach wyszukiwania.

Strategie optymalizacji Crawl Budget na dużą skalę

Skuteczna optymalizacja Crawl Budget na dużą skalę wymaga strategicznego podejścia. Musisz priorytetyzować treści, wprowadzić usprawnienia techniczne i systematycznie zarządzać zawartością. Wszystko po to, żeby Googlebot mógł efektywniej indeksować Twoją witrynę. Połączenie tych działań pozwoli Ci zredukować ilość zbędnych adresów URL, poprawić strukturę serwisu i udostępnić wyszukiwarkom budżet na wartościowe strony.

Na czym polega priorytetyzacja indeksacji ważnych stron?

Priorytetyzacja treści (Content Prioritization) polega na tym, że identyfikujesz strony o wysokiej wartości – na przykład strony landingowe, kluczowe strony usługowe czy Twoje najcenniejsze wpisy blogowe – i dbasz o ich sprawne indeksowanie. Strony o niskiej jakości, przestarzałe lub mało istotne powinny mieć tag „noindex” lub „nofollow”, żeby nie marnować cennego Crawl Budget na ich indeksowanie. To celowe działanie sprawia, że Googlebot skupia się na treściach, które mają największe znaczenie dla Twojego biznesu i użytkowników. Pomyśl o stronach z wynikami wyszukiwania wewnętrznego albo stronach z pustymi kategoriami produktów – oznacz je jako „noindex”.

Jak optymalizować architekturę serwisu i linkowanie wewnętrzne?

Optymalizacja architektury serwisu (Site Architecture Optimization) wymaga utrzymania „płaskiej” struktury, co oznacza, że najważniejsze treści są dostępne maksymalnie w trzech kliknięciach od strony głównej. Taka struktura ułatwia Googlebotowi efektywne poruszanie się po witrynie i szybkie docieranie do istotnych zasobów. Równie ważna jest poprawa linkowania wewnętrznego (Internal Linking Improvement). Polega ona na strategicznym kierowaniu linków wewnętrznych do najważniejszych stron, unikaniu stron osieroconych (czyli bez żadnych linków wewnętrznych) oraz stosowaniu opisowych anchor tekstów. Dzięki temu Googlebot lepiej rozumie kontekst i ważność poszczególnych podstron, a indeksacja Twojej dużej strony staje się bardziej precyzyjna.

Czym jest czyszczenie treści (content pruning) i jak zarządzać jakością i aktualnością treści?

Czyszczenie treści (Content Pruning) to systematyczny proces zarządzania zawartością, który obejmuje usuwanie, łączenie albo odświeżanie przestarzałych, niskiej jakości lub nieefektywnych treści. Dzięki temu działaniu konsolidujesz wartość SEO swojej witryny, a Crawl Budget skupia się na najbardziej wartościowych i angażujących stronach, co poprawia ogólną jakość treści (Content Quality). Przykładowo, usunięcie dziesięciu wpisów blogowych o niskiej jakości, które nie generują ruchu, pozwoli Googlebotowi poświęcić więcej uwagi jednemu, wyczerpującemu artykułowi, który naprawdę przynosi wartość użytkownikom.

Wiele serwisów ma ogromne ilości treści, które nie dają żadnej wartości użytkownikom ani wyszukiwarkom. Częste audyty i eliminacja takich 'balastów’ są podstawą efektywnego zarządzania Crawl Budget.

Jak eliminować duplikaty i parametry URL?

Eliminacja duplikatów (Duplicate Content Elimination) jest po prostu niezbędna! Pomyśl tylko, parametry URL (takie jak filtry, sortowanie czy identyfikatory sesji) mogą generować nieskończoną liczbę niemal identycznych stron, które marnują Twój Crawl Budget. Żeby temu zapobiec, musisz sprawnie zarządzać tymi parametrami. Możesz to zrobić, blokując dostęp do niektórych sekcji w pliku „robots.txt” albo używając tagów kanonicznych, które wskazują preferowaną wersję strony. Użycie tagu „noindex” to również skuteczne rozwiązanie dla stron, które nie powinny być indeksowane, ale muszą pozostać dostępne dla użytkowników.

Jakie znaczenie ma optymalizacja techniczna i analiza logów serwera?

Optymalizacja techniczna (Technical Optimization) to coś więcej niż podstawowe tagi – skupia się na usprawnieniu technicznych aspektów witryny. Musisz przede wszystkim poprawić szybkość strony (Page Speed), co bezpośrednio wpłynie na Crawl Rate Limit. Do tego zredukuj błędy 4xx (strony nieznalezione) i 5xx (błędy serwera), które mogą źle wpłynąć na to, jak Googlebot postrzega jakość Twojej strony. Analiza logów serwera (Server Log Analysis) jest najbardziej precyzyjną metodą, żeby zrozumieć, jak Googlebot zachowuje się na Twojej stronie. Analiza plików logów serwera (Server Log Files) pokaże Ci dokładnie, które strony są odwiedzane, jak często i ile zasobów pochłaniają. Dzięki temu możesz zidentyfikować, gdzie budżet jest marnowany, i priorytetyzować swoje działania optymalizacyjne.

Analiza logów serwera to rentgen dla Twojej witryny. Dzięki niej dokładnie widzisz, gdzie Googlebot marnuje swój czas i możesz precyzyjnie reagować, zamiast zgadywać.

Poniżej znajdziesz podsumowanie głównych strategii optymalizacji Crawl Budget:

| Strategia | Opis | Jak pomaga w optymalizacji Crawl Budget |

|---|---|---|

| Priorytetyzacja treści | Identyfikowanie i oznaczanie ważnych stron (np. landingi, produkty) oraz marginalizowanie mniej istotnych (noindex/nofollow). | Skupia Googlebot na wartościowych treściach, oszczędzając zasoby. |

| Optymalizacja architektury i linkowania | Utrzymywanie „płaskiej” struktury serwisu (maksymalnie 3 kliknięcia od strony głównej) i strategiczne linkowanie wewnętrzne. | Ułatwia Googlebotowi szybkie poruszanie się po witrynie i znajdowanie kluczowych zasobów. |

| Czyszczenie treści (Content Pruning) | Usuwanie, łączenie lub odświeżanie przestarzałych, niskiej jakości treści. | Konsoliduje wartość SEO, skupia budżet na angażujących stronach, poprawia jakość. |

| Eliminacja duplikatów i parametrów URL | Blokowanie dostępu przez robots.txt, stosowanie tagów kanonicznych lub noindex dla zbędnych parametrów URL. | Zapobiega marnowaniu budżetu na indeksowanie niemal identycznych stron. |

| Optymalizacja techniczna i analiza logów | Poprawa szybkości strony, redukcja błędów 4xx/5xx, analiza logów serwera. | Zwiększa Crawl Rate Limit, eliminuje problemy, identyfikuje marnotrawstwo budżetu. |

| Sitemapy tematyczne | Organizacja sitemap według hierarchii treści (Pillar Page, Cluster Pages), tworzenie osobnych sitemap dla różnych typów treści, stosowanie indeksu sitemap (Sitemap Index). | Pomaga Googlebotowi zrozumieć strukturę, priorytetyzuje indeksację ważnych sekcji. |

Skuteczne wykorzystanie sitemap tematycznych

Skuteczne wykorzystanie sitemap tematycznych (Topical Sitemap Management) dla dużych stron to strategiczne podejście do ich organizacji. Ma to pomóc Googlebotowi lepiej zrozumieć hierarchię treści i priorytety indeksowania. Jest to główny element w strategii optymalizacji Crawl Budget, który pozwoli Ci efektywnie kierować uwagę robota na najważniejsze sekcje Twojej witryny.

Jaka jest rola sitemap tematycznych w hierarchii treści?

Sitemapy tematyczne mają bardzo ważną rolę w pomaganiu Googlebotowi zrozumieć hierarchię i kontekst treści w Twoim serwisie. Podstawą jest organizacja treści wokół modelu „Pillar Page” i „Cluster Pages”: strona filarowa to centralna, wyczerpująca strona na szeroki temat, a strony klastrowe to szczegółowe podstrony, które rozwijają konkretne aspekty tego tematu. Tworzenie sitemap, które odzwierciedlają tę logiczną strukturę, znacznie ułatwia Googlebotowi identyfikację relacji między treściami. A to przyspiesza indeksację i poprawia trafność w wynikach wyszukiwania.

Jakie są najlepsze praktyki tworzenia i zarządzania sitemapami?

Najlepsze praktyki tworzenia i zarządzania sitemapami dla dużych serwisów to kilka strategicznych działań, które warto stosować:

- Twórz osobne sitemapy dla różnych typów treści, na przykład dla produktów, wpisów blogowych czy stron statycznych.

- Dla bardzo dużych witryn stosuj indeks sitemap (Sitemap Index), który grupuje wiele mniejszych sitemap. To ułatwia zarządzanie i przetwarzanie przez Googlebot.

- Kluczowe jest, żeby sitemapy zawierały wyłącznie strony indeksowalne, ważne i działające, bez błędów czy duplikatów.

- Automatyzacja generowania sitemap to dziś standard.

- Regularne aktualizowanie znacznika „lastmod” w sitemapach sygnalizuje Googlebotowi o zmianach na stronach, co zachęca go do częstszych odwiedzin i ponownej indeksacji.

Czego unikać w sitemapach?

W sitemapach musisz unikać kilku powszechnych błędów, które mogą marnować Crawl Budget i utrudniać indeksację dużych stron. Przede wszystkim nie wolno umieszczać w nich stron oznaczonych tagiem „noindex”, stron blokowanych przez plik „robots.txt”, stron z błędami 4xx lub 5xx ani duplikatów. Sitemapy nie są magicznym rozwiązaniem problemów z indeksacją, a jedynie przewodnikiem dla Googlebot. Dodawanie do nich niepotrzebnych lub problematycznych adresów URL może wprowadzić robota w błąd i sprawić, że będzie tracił cenne zasoby na mniej istotne ścieżki.

Mierzalne korzyści z optymalizacji Crawl Budget

Skuteczna optymalizacja Crawl Budget przynosi szereg mierzalnych korzyści, które są niezwykle ważne dla dużych stron. Przekłada się to na lepszą widoczność i wydajność serwisu. Wśród tych korzyści znajdziesz szybszą indeksację, poprawę pozycji w wynikach wyszukiwania i mniejsze obciążenie infrastruktury.

Dlaczego zoptymalizowany Crawl Budget zapewnia szybszą indeksację i widoczność w SERP?

Zoptymalizowany Crawl Budget bezpośrednio prowadzi do szybszej indeksacji (Faster Indexing) nowych i zaktualizowanych treści, a także do znacznie lepszej widoczności w wynikach wyszukiwania (Improved SERP Visibility) dla Twoich kluczowych stron. Kiedy Googlebot może efektywniej przeszukiwać Twoją witrynę, poświęca więcej czasu wartościowym podstronom, co przyspiesza ich pojawienie się w wynikach wyszukiwania i wpływa na ich pozycje. Dzięki temu nowe produkty, artykuły czy usługi są szybciej dostępne dla użytkowników, co jest kluczowe dla dużych serwisów, gdzie dynamika zmian jest wysoka.

Czy optymalizacja Crawl Budget przyczynia się do mniejszego obciążenia serwera?

Tak, optymalizacja Crawl Budget bezpośrednio przyczynia się do zmniejszenia obciążenia serwera (Reduced Server Load). Zapobieganie Googlebotowi indeksowania niepotrzebnych stron – takich jak duplikaty, strony z błędami 4xx/5xx czy te oznaczone jako „noindex” – oszczędza zasoby serwera. Mniejsze obciążenie oznacza szybsze ładowanie stron dla rzeczywistych użytkowników i ogólną poprawę wydajności witryny, co jest szczególnie ważne dla dużych stron o dużym ruchu.

Czy istnieją przykłady i dane branżowe potwierdzające korzyści?

Chociaż publicznie dostępne studia przypadków dotyczące optymalizacji Crawl Budget są rzadkością (bo to przecież dane o strategicznym charakterze), raporty branżowe i analizy jednoznacznie potwierdzają wymierne korzyści. Badania pokazują, że wiele witryn z ogromną liczbą podstron ma problem z indeksacją znacznej części swojego contentu bez odpowiedniego technicznego SEO. Lepsze zarządzanie Crawl Budget prowadzi do zwiększenia liczby zaindeksowanych stron i ich lepszej widoczności. W praktyce specjaliści SEO regularnie obserwują wzrost ruchu organicznego i poprawę pozycji w SERP po wdrożeniu strategii optymalizacyjnych, co świadczy o ich skuteczności.

Przyszłość Crawl Budget: AI i ewolucja algorytmów

Przyszłość zarządzania Crawl Budget będzie coraz mocniej kształtowana przez dynamiczny rozwój sztucznej inteligencji (Artificial Intelligence) i ewolucję algorytmów wyszukiwarek (Search Engine Algorithms). Jako specjalista SEO musisz dostosowywać swoje strategie, skupiając się na wydajności, jakości treści i elastyczności, aby sprostać nowym wyzwaniom indeksacji dużych stron.

Jaka jest rola szybkości strony i wydajności serwera w przyszłości Crawl Budget?

Rola optymalizacji wydajności serwera (Server Performance Optimization) i szybkości strony (Page Speed) w przyszłości Crawl Budget będzie jeszcze bardziej istotna. Googlebot coraz intensywniej priorytetyzuje efektywne i szybkie crawlowanie. Oznacza to, że stabilny i wydajny serwer oraz strony ładujące się błyskawicznie bezpośrednio przełożą się na bardziej korzystny Crawl Budget. Wysoka wydajność infrastruktury pozwala robotom odwiedzić więcej stron w tym samym czasie, zmniejszając ich „koszt” dla wyszukiwarki.

Jak AI wpływa na priorytety crawlowania?

Wpływ AI (AI Influence) na priorytety crawlowania jest znaczący. Algorytmy wyszukiwarek, wzbogacone o sztuczną inteligencję, dynamicznie dostosowują swoje działania. Googlebot będzie coraz bardziej koncentrował się na świeżych, unikalnych i wysokiej jakości treściach, które ściśle odpowiadają intencjom użytkownika. To sprawia, że jakość treści (Content Quality) staje się jeszcze ważniejszym czynnikiem wpływającym na Crawl Demand. Algorytmy uczą się, które strony są wartościowe dla użytkowników i to właśnie im przydzielają większy budżet.

Dlaczego elastyczne podejście do SEO jest tak ważne?

Elastyczne podejście do SEO jest niezwykle ważne, ponieważ algorytmy wyszukiwarek, wspomagane przez AI, ewoluują w szybkim tempie, a zachowania użytkowników ciągle się zmieniają. Jako specjalista SEO musisz nieustannie monitorować te zmiany, testować nowe rozwiązania i być gotowym do szybkiej adaptacji swoich strategii, aby utrzymać optymalne wykorzystanie Crawl Budget. Ciągłe uczenie się i reagowanie na nowe sygnały z rynku i wyszukiwarek będzie głównym kluczem do sukcesu dużych stron.

Narzędzia do diagnostyki i monitorowania Crawl Budget

Skuteczna optymalizacja Crawl Budget na dużych stronach wymaga ciągłej diagnostyki i monitorowania, żeby identyfikować problemy i efektywnie alokować zasoby. Dostępnych jest wiele narzędzi, które pomogą Ci zrozumieć, jak Googlebot wchodzi w interakcję z Twoją witryną i gdzie marnowany jest budżet indeksowania.

Jak Google Search Console (GSC) pomaga w monitorowaniu Crawl Budget?

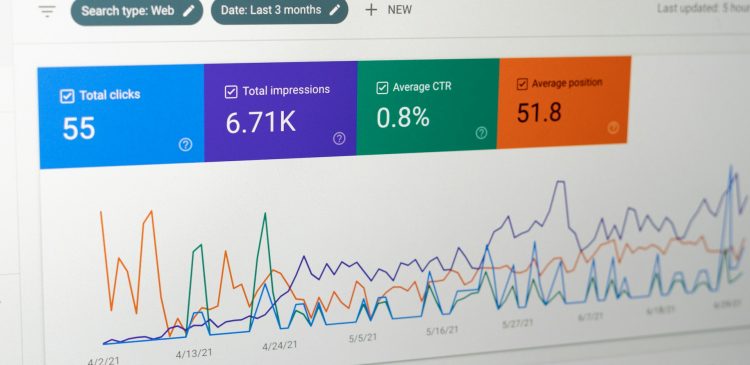

Google Search Console (GSC) to podstawowe narzędzie do monitorowania i zarządzania Crawl Budget. Raport statystyk indeksowania (Crawl Stats Report) w GSC dostarcza danych o aktywności Googlebot, pokazując częstotliwość odwiedzin, liczbę zeskanowanych stron oraz typy plików (HTML, CSS, JS) w ciągu ostatnich 90 dni. Raport pokrycia (Coverage Report) z kolei informuje o liczbie zaindeksowanych stron i tych, które zostały wykluczone. Wskazuje też na potencjalne problemy, takie jak „Odkryto – obecnie nie zaindeksowano” (Discovered – currently not indexed) czy „Zeskanowano – obecnie nie zaindeksowano” (Crawled – currently not indexed). Te raporty są nieocenione, gdy diagnozujesz, gdzie Googlebot napotyka trudności i które obszary wymagają technicznego SEO.

Czy analiza logów serwera jest skuteczna w diagnostyce Crawl Budget?

Tak, analiza logów serwera (Server Log Analysis) jest najbardziej precyzyjną metodą, żeby zrozumieć, jak Googlebot faktycznie wchodzi w interakcję z Twoją witryną. Analizując pliki logów serwera (Server Log Files), możesz dokładnie zobaczyć, które strony są odwiedzane, z jaką częstotliwością i ile czasu Googlebot poświęca na konkretne adresy URL. To pozwoli Ci zidentyfikować strony marnujące Crawl Budget (np. często odwiedzane strony o niskiej wartości, duplikaty) i precyzyjnie kierować działania optymalizacyjne.

Jak crawlery SEO wspierają zarządzanie Crawl Budget?

Crawlery SEO, takie jak Screaming Frog, Sitebulb, DeepCrawl czy OnCrawl, mają bardzo ważną rolę, bo symulują zachowanie Googlebot na stronie. Te narzędzia pomagają Ci identyfikować szeroki zakres problemów technicznych, które mogą wpływać na Crawl Budget, w tym:

- Uszkodzone linki i przekierowania.

- Głębokie struktury linkowania.

- Problemy z indeksacją (np. tagi „noindex”).

- Duplikaty treści.

Te dane są niezbędne do wdrożenia skutecznych działań w celu optymalizacji Crawl Budget.

Jakie inne narzędzia i praktyki warto stosować?

Oprócz wymienionych, warto korzystać z zaawansowanych narzędzi SEO, takich jak Ahrefs czy Semrush, które oferują szerszą perspektywę na widoczność, linkowanie i zdrowie techniczne Twojej witryny. Ustawianie automatycznych alertów na anomalie crawlowania, błędy serwera czy problemy z indeksacją pozwala na szybką reakcję. Pamiętaj, że kluczowe jest również ciągłe monitorowanie wskaźników bazowych i dostosowywanie strategii, żeby utrzymać optymalne wykorzystanie Crawl Budget.

Podsumowanie

Optymalizacja Crawl Budget to absolutna podstawa dla dużych stron, które marzą o wysokiej widoczności w wynikach wyszukiwania i efektywnej indeksacji. Kompleksowe podejście, które łączy priorytetyzację treści (Content Prioritization), rygorystyczne czyszczenie treści (Content Pruning) oraz inteligentne zarządzanie sitemapami tematycznymi (Topical Sitemap Management), stworzy solidne fundamenty. Wspierane przez ciągłą optymalizację techniczną (Technical Optimization) i uważne monitorowanie za pomocą narzędzi takich jak Google Search Console i analiza logów serwera, strategie te zagwarantują Ci lepszą widoczność w SERP (Improved SERP Visibility) i szybszą indeksację (Faster Indexing). Widzisz, strategiczne zarządzanie zasobami Googlebot jest niezbędne, żeby utrzymać konkurencyjność w dzisiejszym cyfrowym świecie.

Masz duży serwis, który boryka się z problemami z indeksacją? Skontaktuj się z naszymi ekspertami SEO, żeby przeprowadzić kompleksowy audyt Crawl Budget już dziś!

FAQ – najczęściej zadawane pytania o Crawl Budget

Czym dokładnie jest Crawl Budget i dlaczego jest ważny dla dużych serwisów?

Crawl Budget to ograniczona liczba stron, które Googlebot może i chce odwiedzić na Twojej witrynie w danym czasie, co stanowi połączenie jego możliwości technicznych i postrzeganego zapotrzebowania na indeksację. Jest on niezwykle ważny dla dużych stron, ponieważ zasoby indeksowania są skończone, a efektywne zarządzanie nimi decyduje o tym, czy najważniejsze treści zostaną szybko odkryte i zaindeksowane, co wpływa na ich widoczność w wyszukiwarce.

Jakie są główne czynniki wpływające na wysokość mojego Crawl Budget?

Główne czynniki wpływające na wysokość Crawl Budget to Crawl Rate Limit, czyli techniczne ograniczenia serwera (np. Page Speed i Server Stability), oraz Crawl Demand, czyli postrzegane zapotrzebowanie wyszukiwarki na indeksację (zależne od Content Quality, Website Popularity i Content Update Frequency). Dodatkowo, autorytet domeny (Domain Authority) Twojej witryny również odgrywa istotną rolę.

Co to jest czyszczenie treści (Content Pruning) i jak pomaga w optymalizacji Crawl Budget?

Czyszczenie treści (Content Pruning) to proces systematycznego usuwania, łączenia lub odświeżania treści niskiej jakości, przestarzałej lub nieefektywnej, aby skoncentrować Crawl Budget na wartościowych stronach. Pomaga to w optymalizacji Crawl Budget poprzez eliminację „balastu”, konsolidację wartości SEO i zwiększenie uwagi Googlebot na najbardziej istotnych dla użytkownika i biznesu treściach.

Czy sitemapy tematyczne są naprawdę konieczne dla dużych witryn?

Tak, zarządzanie sitemapami tematycznymi (Topical Sitemap Management) jest bardzo konieczne dla dużych stron, ponieważ pomaga Googlebotowi zrozumieć złożoną strukturę i hierarchię treści, szczególnie w modelu „Pillar Page” i „Cluster Pages”. Uporządkowane sitemapy tematyczne ułatwiają robotom odnajdywanie kluczowych stron, co przyspiesza indeksację dużych stron i poprawia ich ogólną widoczność w wynikach wyszukiwania.

Jakie narzędzia pomogą mi monitorować mój Crawl Budget?

Do monitorowania Crawl Budget warto używać Google Search Console (szczególnie raporty Crawl Stats i Coverage Report), która dostarcza podstawowych informacji o aktywności Googlebot. Najdokładniejsza jest analiza logów serwera (Server Log Analysis), która pokazuje rzeczywiste zachowanie robota na witrynie. Dodatkowo, crawlery SEO takie jak Screaming Frog czy Sitebulb pomagają w diagnostyce technicznych problemów, które mogą wpływać na budżet indeksowania.

Poszukujesz agencji SEO w celu wypozycjonowania swojego serwisu? Skontaktujmy się!

Paweł Cengiel

Cechuję się holistycznym podejściem do SEO, tworzę i wdrażam kompleksowe strategie, które odpowiadają na konkretne potrzeby biznesowe. W pracy stawiam na SEO oparte na danych (Data-Driven SEO), jakość i odpowiedzialność. Największą satysfakcję daje mi dobrze wykonane zadanie i widoczny postęp – to jest mój „drive”.

Wykorzystuję narzędzia oparte na sztucznej inteligencji w procesie analizy, planowania i optymalizacji działań SEO. Z każdym dniem AI wspiera mnie w coraz większej liczbie wykonywanych czynności i tym samym zwiększa moją skuteczność.